工具瓶颈:AI/MCP工具过载问题概述

1. 引言:能力的悖论

智能体AI的操作范式核心在于模型选择和利用一套外部工具的能力——从日历管理和电子邮件客户端到复杂的数据库查询和网络搜索API。其目标是创建一个能够执行多步骤、真实世界任务的通用助手。一个合乎逻辑但存在缺陷的假设是,更大的工具集等同于更强大的智能体。

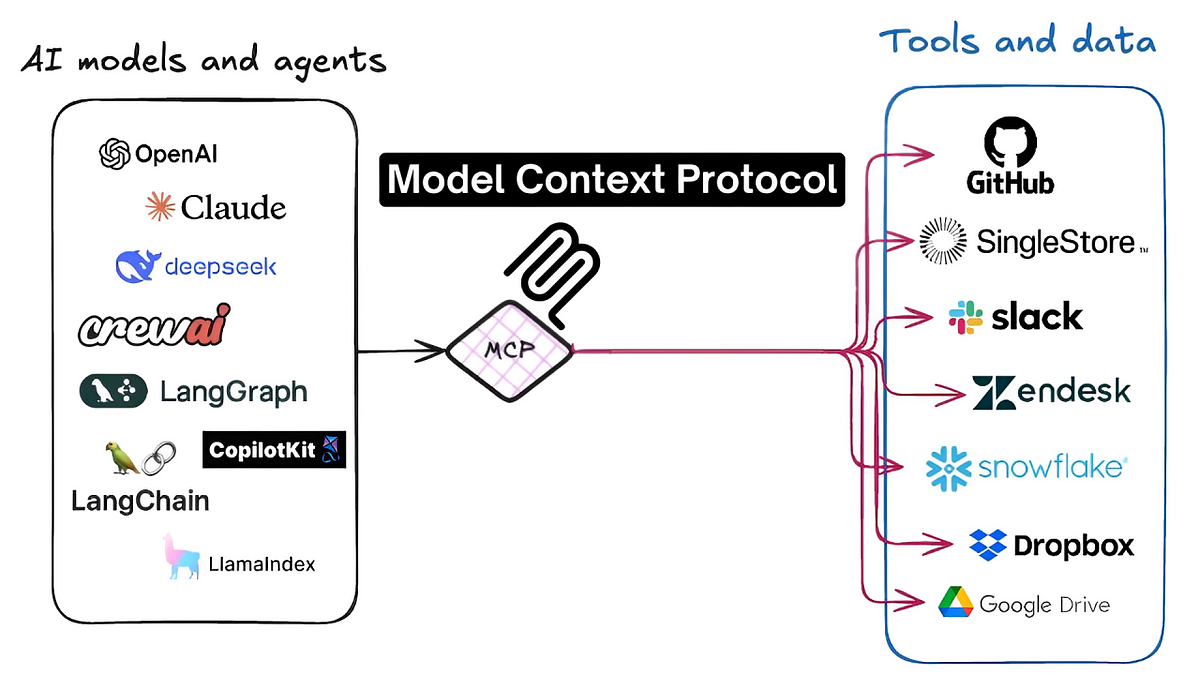

在实践中,一个关键的扩展性问题已经出现。随着可用工具数量的增加,底层大语言模型(LLM)的性能并非线性扩展。相反,它进入了一种退化状态,其特征是工具选择准确性降低、任务失败率增加以及运营成本更高。这种“工具过载”并非一个边缘问题,而是对当前构建智能体系统方法的根本性挑战。正如一位开发者在Hacker News上讨论工具集成标准Model Context Protocol (MCP)时所阐述的,这个问题是基础性的:“我的观点是,不断增加工具是无法扩展且行不通的。只有当你拥有少数工具时才有效。如果你启用了50个MCP服务器,你的请求质量可能会下降。” (来源)。

这种现象正在造成一种切实的挫败感。开发者乃至普通用户都报告感到不知所措,一位Reddit用户将他使用多个AI工具的经历描述为“混乱”,并且记不清“哪个工具用在了什么地方”。(

)。本文将从技术角度解构这个问题,并以学术研究和开发者论坛的证据为支撑,将工具瓶颈正式定义为AI未来发展的主要障碍。2. 工具过载问题的技术基础

工具过载问题源于当代LLM的架构限制,主要与其有限的上下文窗口和注意力机制有关。尽管上下文窗口已大幅扩展,但利用该空间的方法并未跟上步伐,导致了显著的性能权衡。

2.1. 上下文窗口膨胀与推理能力下降

LLM使用工具的能力取决于该工具的定义是否存在于其上下文窗口中——即模型的有效短期记忆。这一定义包括工具的名称、其功能的自然语言描述及其参数。随着添加的工具越来越多,这些定义的总大小,即“令牌膨胀”,会消耗掉上下文窗口中越来越大的部分。

这带来了两个负面后果。首先,它直接增加了每个请求的计算成本和延迟。正如Meibel AI的研究所示,输入令牌的数量与生成输出令牌所需的时间之间存在直接关联。(来源)。其次,也是更关键的是,它挤占了可用于实际任务特定上下文的空间。这包括用户的指令、对话历史以及模型为解决问题而需要进行的中间“思考”。正如Sean Blanchfield在他的分析文章《The MCP Tool Trap》中指出的,这迫使我们在提供详细的工具描述(以确保准确性)和为模型的推理过程留出足够空间之间做出妥协。

2.2. 准确性下降与“中间遗忘”问题

当LLM面对大量工具时,其为给定任务选择正确工具的能力会下降。模型的“注意力”机制必须评估更多的可能性,这增加了出错的概率。这种情况因“中间遗忘”现象而加剧,即模型在回忆位于上下文窗口开头或结尾的信息时表现更好,而中间的信息常常被忽略或记错。

这可能表现为:

- 工具选择错误: 选择一个功能上不适合任务的工具。

- 参数幻觉: 调用了正确的工具,但使用了虚构或不正确的参数。

- 工具干扰: 名称相似或功能重叠的工具描述可能会“迷惑”模型,导致不可预测的行为。

这一现象得到了经验支持。研究论文《少即是多:关于大型语言模型工具选择的研究》表明,可用工具的数量与工具调用准确性之间存在明显的负相关关系。r/AI_Agents subreddit上的一位开发者从实践角度证实了这一点:“[一旦一个智能体需要访问5个以上的工具……准确性就会下降。链接多个工具调用变得不可靠。]” (

)。

3. 案例研究:Model Context Protocol (MCP) 生态系统

工具过载问题在MCP生态系统中尤为突出。MCP是一个标准化协议,旨在促进AI智能体与数千个第三方工具(MCP服务器)之间的无缝交互。虽然该标准催化了创新,但它也成为了扩展性问题的焦点。

MCP的设计本身依赖于可发现的、自然语言的工具定义,这直接将智能体暴露在上下文窗口膨胀和注意力不足的问题之下。用户和开发者的诱惑是启用大量的MCP服务器,以最大化智能体的潜在能力。然而,正如一位Hacker News评论者有力地指出的,这种方法从根本上就是错误的:

“MCP无法扩展。它无法扩展到某个阈值以上。在不负面影响智能体能力的情况下,向其上下文中添加无限数量的工具是不可能的。这是整个MCP概念的根本限制……你会看到像‘MCP以前很好,但现在…’这样的帖子,因为人们体验到了启用许多MCP服务器的影响。它们会相互干扰。” (来源)

这凸显了问题不仅仅是实现细节,而是当前“全部加载”方法固有的架构挑战。另一场讨论指出,瓶颈在于模型本身,它们*“当你给它们太多工具调用时会很吃力。当给予功能重叠或函数名/参数相似的工具时,它们不善于评估要使用的正确工具。”* (来源)。这些技术社区的共识是,如果没有解决方案,通过MCP实现一个庞大、互联的工具生态系统的承诺将无法实现,受限于它试图赋能的模型本身的认知能力。

4. 提议的解决方案架构

业界正趋向于采用两种主要方法来缓解工具过载问题。这些解决方案旨在摆脱为每个任务将所有可用工具加载到上下文窗口中的幼稚方法,这种做法已被证明是低效且容易出错的。

4.1. 服务器端解决方案:工具抽象与层级结构

这种方法侧重于使工具服务器本身更加智能。服务器端解决方案可以将大量粒度化的低级工具抽象为更高级别的复合能力,而不是将它们全部暴露给智能体。这减少了LLM在任何给定时间需要做出的选择数量。

Klavis AI提出的“strata”概念就是一个例子。根据他们的API文档,该系统允许动态创建工具层级。这可以使智能体首先选择一个广泛的类别(例如,“文件管理”),然后才被呈现一个更小、更相关的工具子集(例如,“create_file”、“update_file”),从而在每一步都减轻模型的认知负荷。

4.2. 客户端解决方案:动态工具选择与过滤

这种方法将智能置于协调AI智能体的客户端应用程序中。核心思想是实现一个预处理或路由层,在与主LLM交互之前分析用户的意图。该层负责从一个更大的库中动态选择一个小的、高度相关的工具子集,并仅将这些工具注入到特定任务的上下文窗口中。

**Jenova**采取的方法就是一个例子,它使用一个中介系统,根据用户的自然语言请求智能地过滤和排序可用工具。正如在《The Tooling Bottleneck》的分析中详细介绍的,这种方法为LLM创建了一个“即时”工具集。通过这样做,它保持了上下文窗口的精简和专注,从而保留了模型的推理能力并显著提高了工具选择的准确性。这与Memgraph的见解一致,后者认为关键是“在正确的时间,以结构化的方式,为LLM提供正确的上下文”,而不仅仅是构建更大的模型。(来源)。

5. 结论:迈向可扩展的智能体架构

工具过载问题是发展有能力的通用AI智能体的一个重大且根本的瓶颈。最大化工具数量的初始策略已被证明是一个谬误,导致性能下降、可靠性降低和用户体验不佳。来自学术研究和广泛开发者讨论的证据表明了一个明确的共识:原始地扩展工具输入是一个架构上的死胡同。

正如麦肯锡一份关于智能体AI的报告所指出的,扩展需要一个新的“智能体AI网格”——一个模块化且有弹性的架构——来管理日益增长的技术债务和新类别的风险。(来源)。前进的道路不在于限制可用工具的数量,而在于开发更复杂的架构来管理它们。智能体AI的未来将取决于能够智能、动态地管理上下文的系统。无论是通过服务器端抽象还是客户端动态过滤,下一代AI智能体都必须能够精确而专注地在广阔的潜在工具海洋中航行。克服这个工具瓶颈是从功能有限的AI向真正可扩展和智能的智能体系统演进中必要而关键的一步。