Проблема Инструментария: Обзор Проблемы Перегрузки Инструментов в AI/MCP

1. Введение: Парадокс возможностей

Операционная парадигма для агентного ИИ сосредоточена на способности модели выбирать и использовать набор внешних инструментов — от управления календарем и почтовых клиентов до сложных запросов к базам данных и API веб-поиска. Цель состоит в создании универсального помощника, способного выполнять многоэтапные задачи реального мира. Логичное, но ошибочное предположение заключалось в том, что больший набор инструментов равносилен более мощному агенту.

На практике возникла критическая проблема масштабирования. По мере увеличения количества доступных инструментов производительность базовой большой языковой модели (LLM) не масштабируется линейно. Вместо этого она входит в состояние деградации, характеризующееся снижением точности выбора инструментов, увеличением частоты сбоев задач и более высокими операционными затратами. Эта «перегрузка инструментами» — не второстепенная проблема, а фундаментальный вызов текущему подходу к созданию агентных систем. Как сформулировал один разработчик на Hacker News в обсуждении Model Context Protocol (MCP), стандарта для интеграции инструментов, проблема является основополагающей: «Моя точка зрения в том, что добавление все большего и большего количества инструментов не масштабируется и не работает. Это работает только тогда, когда у вас есть несколько инструментов. Если у вас включено 50 серверов MCP, ваши запросы, вероятно, будут ухудшаться». (Источник).

Это явление создает ощутимое чувство разочарования. Разработчики и даже обычные пользователи сообщают о чувстве перегруженности; один пользователь Reddit описал свой опыт с несколькими инструментами ИИ как «хаотичный» и потерю понимания, «какой инструмент я для чего использовал». (

). В этой статье мы разберем эту проблему с технической точки зрения, опираясь на данные академических исследований и форумов разработчиков, чтобы формализовать проблему инструментария как основное препятствие для будущего ИИ.2. Технические основы проблемы перегрузки инструментов

Проблема перегрузки инструментов проистекает из архитектурных ограничений современных LLM, в первую очередь связанных с их конечными окнами контекста и механизмами внимания. Хотя окна контекста значительно расширились, методы использования этого пространства не успевают за ними, что приводит к значительным компромиссам в производительности.

2.1. Раздувание окна контекста и деградация рассуждений

Способность LLM использовать инструмент зависит от наличия определения этого инструмента в его окне контекста — эффективной кратковременной памяти модели. Это определение включает имя инструмента, описание его функции на естественном языке и его параметры. По мере добавления новых инструментов совокупный размер этих определений, или «раздувание токенов», занимает все большую часть окна контекста.

Это имеет два негативных последствия. Во-первых, это напрямую увеличивает вычислительные затраты и задержку каждого запроса. Как показывают исследования Meibel AI, существует прямая корреляция между количеством входных токенов и временем, необходимым для генерации выходного токена. (Источник). Во-вторых, что более важно, это вытесняет пространство, доступное для фактического контекста, специфичного для задачи. Сюда входят инструкции пользователя, история разговора и промежуточные «мысли», необходимые модели для решения проблемы. Как отмечает Шон Блэнчфилд в своем анализе «Ловушка инструментов MCP», это заставляет идти на компромисс между предоставлением подробных описаний инструментов (для точности) и оставлением достаточного пространства для процесса рассуждений модели.

2.2. Снижение точности и проблема «потери в середине»

Когда LLM предоставляется обширный набор инструментов, его способность выбрать правильный для данной задачи ухудшается. Механизм «внимания» модели должен оценивать большее количество возможностей, что увеличивает вероятность ошибки. Это усугубляется феноменом «потери в середине», когда модели показывают лучшую производительность при извлечении информации, размещенной в начале или в конце окна контекста, в то время как информация в середине часто игнорируется или запоминается неверно.

Это может проявляться как:

- Неправильный выбор инструмента: Выбор инструмента, который функционально не подходит для задачи.

- Галлюцинация параметров: Вызов правильного инструмента, но с выдуманными или неверными параметрами.

- Взаимодействие инструментов: Описания инструментов с похожими названиями или пересекающимися функциями могут «запутать» модель, что приводит к непредсказуемому поведению.

Это явление подтверждается эмпирически. Исследовательская работа «Меньше значит больше: о выборе инструментов для больших языковых моделей» демонстрирует четкую отрицательную корреляцию между количеством доступных инструментов и точностью вызова инструментов. Разработчик на сабреддите r/AI_Agents подтверждает это с практической точки зрения: «[как только агент получает доступ к 5+ инструментам... точность падает. Цепочка из нескольких вызовов инструментов становится ненадежной.]» (

).

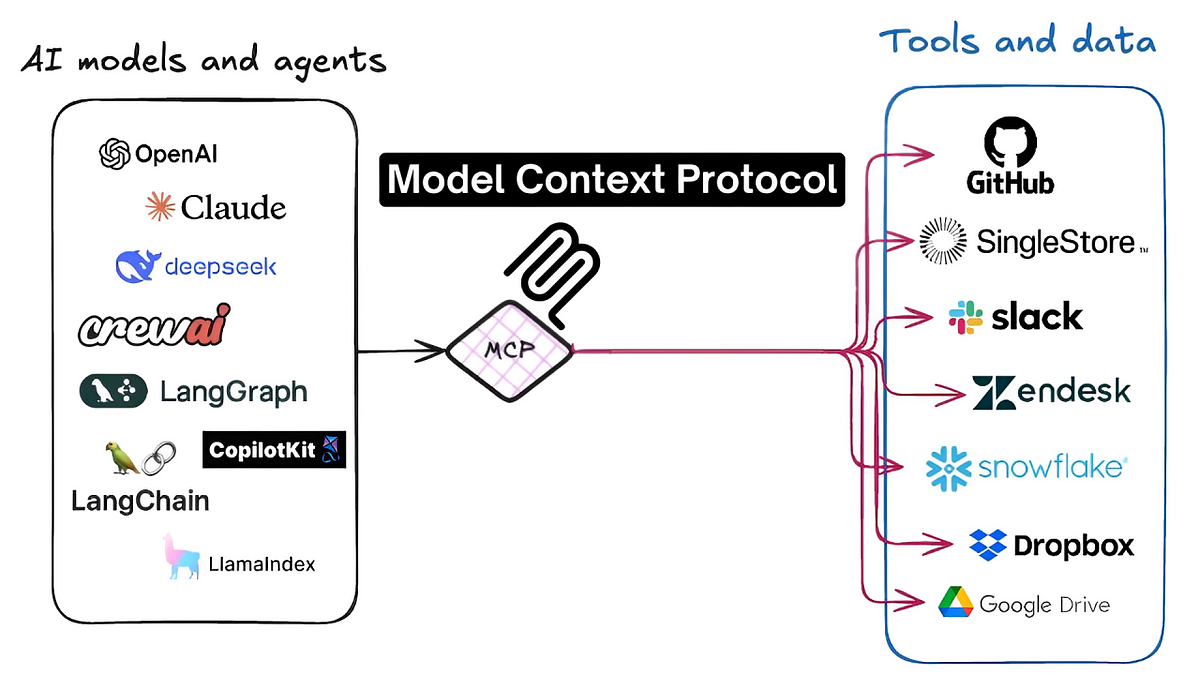

3. Пример из практики: Экосистема Model Context Protocol (MCP)

Проблема перегрузки инструментов особенно остро стоит в экосистеме MCP. MCP — это стандартизированный протокол, разработанный для обеспечения беспрепятственного взаимодействия между агентами ИИ и тысячами сторонних инструментов (серверов MCP). Хотя этот стандарт стимулировал инновации, он также стал центральной точкой проблемы масштабирования.

Сама конструкция MCP, основанная на обнаруживаемых определениях инструментов на естественном языке, напрямую подвергает агентов проблемам раздувания окна контекста и дефицита внимания. У пользователей и разработчиков возникает соблазн включить большое количество серверов MCP, чтобы максимизировать потенциальные возможности агента. Однако, как убедительно заявил комментатор на Hacker News, этот подход в корне ошибочен:

«MCP не масштабируется. Он не может масштабироваться за пределы определенного порога. Невозможно добавить неограниченное количество инструментов в контекст ваших агентов, не оказав негативного влияния на возможности вашего агента. Это фундаментальное ограничение всей концепции MCP... Вы увидите посты вроде «MCP раньше был хорош, а теперь…», когда люди столкнутся с последствиями включения множества серверов MCP. Они мешают друг другу». (Источник)

Это подчеркивает, что проблема — не просто деталь реализации, а архитектурная проблема, присущая текущему подходу «загрузить все». В другой дискуссии было отмечено, что узким местом являются сами модели, которые «испытывают трудности, когда им дают слишком много инструментов для вызова. Они плохо оценивают правильный инструмент для использования, когда им предоставляются инструменты с пересекающейся функциональностью или похожими именами/аргументами функций». (Источник). Консенсус в этих технических сообществах заключается в том, что без решения обещание обширной, взаимосвязанной экосистемы инструментов через MCP останется невыполненным, ограниченным когнитивными способностями тех самых моделей, которые он стремится расширить.

4. Предлагаемые архитектуры решений

Индустрия сходится на двух основных подходах к смягчению проблемы перегрузки инструментов. Эти решения направлены на отход от наивного метода загрузки всех доступных инструментов в окно контекста для каждой задачи, практики, которая оказалась неэффективной и подверженной ошибкам.

4.1. Решения на стороне сервера: Абстракция и иерархии инструментов

Этот подход фокусируется на том, чтобы сделать сами серверы инструментов более интеллектуальными. Вместо того чтобы предоставлять агенту большое количество гранулярных, низкоуровневых инструментов, решение на стороне сервера может абстрагировать их в более высокоуровневые, составные возможности. Это уменьшает количество вариантов выбора, которые LLM должен сделать в любой момент времени.

Примером этого является концепция «strata», предложенная Klavis AI. Согласно их документации API, эта система позволяет динамически создавать иерархии инструментов. Это может позволить агенту сначала выбрать широкую категорию (например, «управление файлами»), а затем ему будет представлен меньший, более релевантный набор инструментов (например, «create_file», «update_file»), тем самым снижая когнитивную нагрузку на модель на каждом шаге.

4.2. Решения на стороне клиента: Динамический выбор и фильтрация инструментов

Этот подход размещает интеллект в клиентском приложении, которое управляет агентом ИИ. Основная идея заключается в реализации слоя предварительной обработки или маршрутизации, который анализирует намерение пользователя перед взаимодействием с основной LLM. Этот слой отвечает за динамический выбор небольшого, высокорелевантного подмножества инструментов из гораздо большей библиотеки и внедрение только их в окно контекста для конкретной задачи.

Примером этого является подход, принятый Jenova, который использует промежуточную систему, интеллектуально фильтрующую и ранжирующую доступные инструменты на основе запроса пользователя на естественном языке. Как подробно описано в анализе, найденном в «Проблема Инструментария», этот метод создает «своевременный» набор инструментов для LLM. Таким образом, он сохраняет окно контекста компактным и сфокусированным, тем самым сохраняя способность модели к рассуждениям и значительно улучшая точность выбора инструментов. Это согласуется с идеями Memgraph, которые утверждают, что ключ в том, чтобы «предоставлять LLM правильный контекст, в нужное время, структурированным образом», а не просто создавать более крупные модели. (Источник).

5. Заключение: На пути к масштабируемым агентным архитектурам

Проблема перегрузки инструментов представляет собой значительное и фундаментальное узкое место на пути развития способных, универсальных агентов ИИ. Первоначальная стратегия максимизации количества инструментов оказалась ошибочной, что привело к снижению производительности, уменьшению надежности и плохому пользовательскому опыту. Данные как академических исследований, так и обширных обсуждений разработчиков указывают на ясный консенсус: простое масштабирование вводимых инструментов — это архитектурный тупик.

Как отмечается в отчете McKinsey об агентном ИИ, для масштабирования требуется новая «агентная сетка ИИ» — модульная и устойчивая архитектура — для управления растущим техническим долгом и новыми классами рисков. (Источник). Путь вперед лежит не в ограничении количества доступных инструментов, а в разработке более сложных архитектур для их управления. Будущее агентного ИИ будет зависеть от систем, которые могут интеллектуально и динамически управлять контекстом. Будь то через серверную абстракцию или клиентскую динамическую фильтрацию, следующее поколение агентов ИИ должно уметь с точностью и фокусом ориентироваться в огромном океане потенциальных инструментов. Преодоление этой проблемы инструментария является необходимым и критическим шагом в эволюции от функционально ограниченного ИИ к действительно масштабируемым и интеллектуальным агентным системам.