ツーリングのボトルネック:AI/MCPにおけるツール過負荷問題の概要

1. はじめに:能力のパラドックス

エージェント型AIの運用パラダイムは、カレンダー管理やメールクライアントから、複雑なデータベースクエリやウェブ検索APIまで、一連の外部ツールを選択し活用するモデルの能力に中心を置いています。その目的は、多段階の実世界タスクを実行できる多才なアシスタントを作成することです。より大きなツールセットがより強力なエージェントに等しいという、論理的でありながら欠陥のある仮定がなされてきました。

実際には、重大なスケーリング問題が浮上しています。利用可能なツールの数が増えるにつれて、基盤となる大規模言語モデル(LLM)のパフォーマンスは線形にスケールしません。代わりに、ツール選択の精度の低下、タスク失敗率の増加、運用コストの上昇を特徴とする劣化状態に陥ります。この「ツール過負荷」は周辺的な問題ではなく、エージェント型システムを構築する現在の アプローチに対する根本的な挑戦です。Hacker Newsのある開発者が、ツール統合の標準であるModel Context Protocol (MCP)についての議論で明確に述べたように、問題は根源的なものです:「私の言いたいことは、ツールをどんどん追加してもスケールしないし、機能しないということです。機能するのは少数のツールがある場合だけです。50のMCPサーバーを有効にしたら、リクエストの質は恐らく低下するでしょう。」 (出典).

この現象は、具体的なフラストレーションを生み出しています。開発者や一般ユーザーでさえも圧倒されていると報告しており、あるRedditユーザーは複数のAIツールを使った経験を「混沌としている」と述べ、「どのツールを何に使ったか」わからなくなると語っています。(

). この記事では、学術研究や開発者フォーラムからの証拠に裏打ちされた技術的観点からこの問題を解体し、ツーリングのボトルネックをAIの未来における主要な障害として形式化します。2. ツール過負荷問題の技術的基盤

ツール過負荷問題は、現代のLLMのアーキテクチャ上の制限、主としてその有限なコンテキストウィンドウと注意メカニズムに関連して生じます。コンテキストウィンドウは劇的に拡大しましたが、そのスペースを活用する方法は追いついておらず、重大なパフォーマンスのトレードオフにつながっています。

2.1. コンテキストウィンドウの肥大化と推論能力の低下

LLMがツールを使用する能力は、そのツールの定義がコンテキストウィンドウ内(モデルの効果的な短期記憶)に存在することに依存します。この定義には、ツールの名前、その機能の自然言語による説明、およびそのパラメータが含まれます。ツールが追加されるにつれて、これらの定義の総サイズ、すなわち「トークンの肥大化」がコンテキストウィンドウのますます大きな部分を消費します。

これには2つの悪影響があります。第一に、すべてのリクエストの計算コストとレイテンシを直接増加させます。Meibel AIの研究が示すように、入力トークンの数と出力トークンを生成する時間との間には直接的な相関関係があります。(出典). 第二に、より重要なこととして、実際のタスク固有のコンテキストに利用できるスペースを圧迫します。これには、ユーザーの指示、会話の履歴、そしてモデルが問題を推論するために必要な中間的な「思考」が含まれます。Sean Blanchfieldが彼の分析「The MCP Tool Trap」で指摘しているように、これは詳細なツール説明を提供すること(精度のために)と、モデルの推論プロセスのために十分なスペースを残すこととの間の妥協を強いることになります。

2.2. 精度の低下と「中間での喪失」問題

LLMに広範なツールセットが提示されると、特定のタスクに対して正しいものを選択する能力が低下します。モデルの「注意」メカニズムはより多くの可能性を評価しなければならず、これがエラーの確率を高めます。これは「中間での喪失」現象によってさらに悪化します。この現象では、モデルはコンテキストウィンドウの最初または最後に配置された情報を思い出すパフォーマンスが向上する一方で、中間の情報はしばしば無視されたり、誤って記憶されたりします。

これは次のように現れることがあります:

- 不適切なツール選択: タスクに対して機能的に不適切なツールを選択する。

- パラメータの幻覚: 正しいツールを呼び出すが、架空のまたは不正確なパラメータを使用する。

- ツールの干渉: 似た名前や機能的に重複するツールの説明がモデルを「混乱」させ、予測不可能な振る舞いを引き起こす。

この現象は経験的に裏付けられています。研究論文「Less is More: On the Selection of Tools for Large Language Models」は、利用可能なツールの数とツール呼び出しの精度との間に明確な負の相関関係があることを示しています。r/AI_Agentsサブレディットのある開発者は、実践的な観点からこれを裏付けています:「[エージェントが5つ以上のツールにアクセスできるようになると...精度が落ちる。複数のツール呼び出しを連鎖させることが信頼できなくなる。]」 (

).

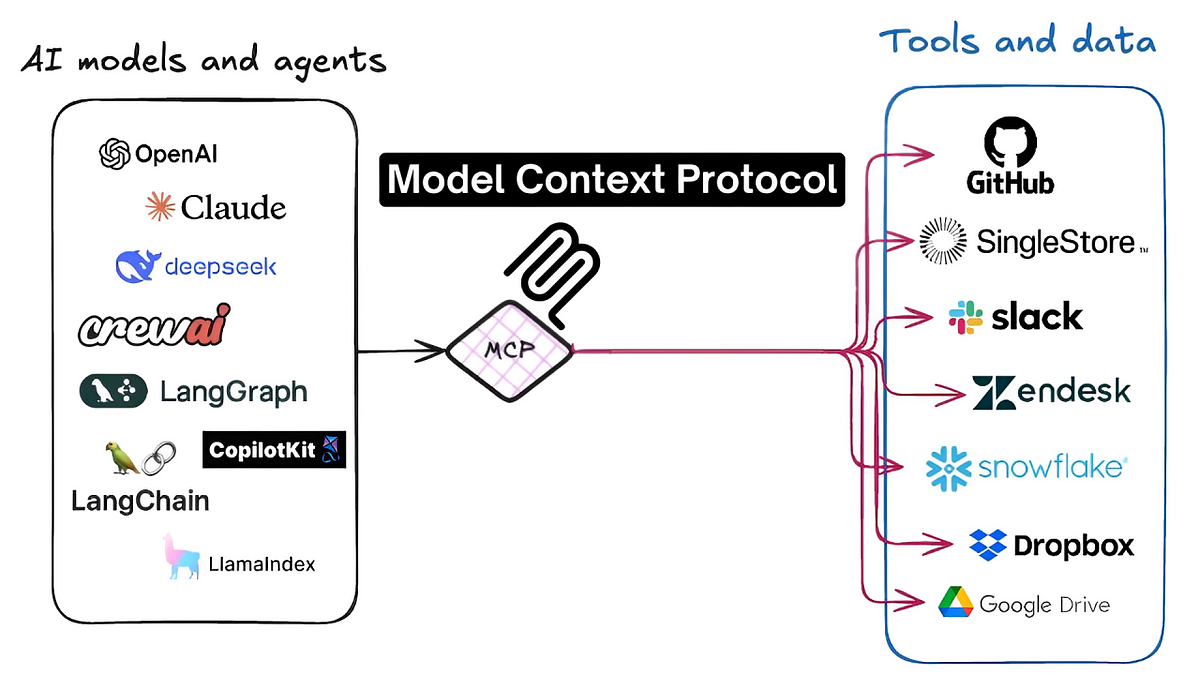

3. ケーススタディ:Model Context Protocol (MCP) エコシステム

ツール過負荷問題は、MCPエコシステム内で特に深刻です。MCPは、AIエージェントと何千ものサードパーティツール(MCPサーバー)との間のシームレスな相互作用を促進するために設計された標準化プロトコルです。この標準はイノベーションを触媒しましたが、スケーリング問題の焦点にもなっています。

発見可能な自然言語のツール定義に依存するMCPの設計そのものが、エージェントをコンテキストウィンドウの肥大化と注意欠陥の問題に直接さらします。ユーザーや開発者にとっての誘惑は、エージェントの潜在能力を最大化するために多数のMCPサーバーを有効にすることです。しかし、Hacker Newsのコメント投稿者が力強く述べたように、このアプローチは根本的に欠陥があります:

「MCPはスケールしない。特定の閾値を超えてスケールすることはできない。エージェントの能力に悪影響を与えることなく、無制限の数のツールをエージェントのコンテキストに追加することは不可能だ。これはMCPの概念全体の根本的な制限だ... 多くのMCPサーバーを有効にしたことによる影響を人々が経験するにつれて、『MCPは以前は良かったが今は…』のような投稿を目にするようになるだろう。それらはお互いに干渉し合う。」 (出典)

これは、問題が単なる実装の詳細ではなく、現在の「すべてをロードする」アプローチに内在するアーキテクチャ上の課題であることを浮き彫りにしています。別の議論では、ボトルネックはモデル自体であり、*「呼び出すツールが多すぎると苦労する。機能が重複するツールや、関数名/引数が似ているツールを与えられた場合、正しいツールを評価するのが苦手だ。」*と指摘されています。(出典). これらの技術コミュニティでのコンセンサスは、解決策がなければ、MCPを介した広大で相互接続されたツールエコシステムの約束は、それを強化しようとするモデル自体の認知能力によって制限され、未実現のままになるということです。

4. 提案される解決策アーキテクチャ

業界は、ツール過負荷問題を軽減するために、主に2つのアプローチに収束しつつあります。これらの解決策は、すべてのタスクに対して利用可能なすべてのツールをコンテキストウィンドウにロードするという、非効率でエラーを起こしやすいことが証明されたナイーブな方法から脱却することを目指しています。

4.1. サーバーサイドソリューション:ツールの抽象化と階層化

このアプローチは、ツールサーバー自体をよりインテリジェントにすることに焦点を当てています。エージェントに多数の粒度の細かい低レベルのツールを公開する代わりに、サーバーサイドソリューションはそれらをより高レベルの複合的な能力に抽象化することができます。これにより、LLMが特定の時点で行わなければならない選択の数が減少します。

この一例が、Klavis AIによって提案された「strata」コンセプトです。彼らのAPIドキュメントによると、このシステムはツール階層の動的な作成を可能にします。これにより、エージェントはまず広範なカテゴリ(例:「ファイル管理」)を選択し、その後でより小さく、より関連性の高いツールのサブセット(例:「create_file」、「update_file」)を提示されることが可能になり、各ステップでモデルの認知負荷を軽減します。

4.2. クライアントサイドソリューション:動的なツール選択とフィルタリング

このアプローチは、AIエージェントを調整するクライアントアプリケーション内にインテリジェンスを配置します。中心的なアイデアは、プライマリLLMを関与させる前にユーザーの意図を分析する前処理またはルーティング層を実装することです。この層は、はるかに大きなライブラリから小さく、非常に関連性の高いツールのサブセットを動的に選択し、特定のタスクのためにそれらだけをコンテキストウィンドウに注入する責任があります。

この一例が、**Jenova**が採用したアプローチです。これは、ユーザーの自然言語リクエストに基づいて利用可能なツールをインテリジェントにフィルタリングし、ランク付けする中間システムを使用します。「The Tooling Bottleneck」にある分析で詳述されているように、この方法はLLMのために「ジャストインタイム」のツールセットを作成します。そうすることで、コンテキストウィンドウをスリムで焦点の合った状態に保ち、モデルの推論能力を維持し、ツール選択の精度を劇的に向上させます。これはMemgraphの洞察と一致しており、重要なのは単に大きなモデルを構築するのではなく、「LLMに正しいコンテキストを、正しいタイミングで、構造化された方法で供給する」ことだと主張しています。(出典).

5. 結論:スケーラブルなエージェント型アーキテクチャに向けて

ツール過負荷問題は、有能で汎用的なAIエージェントの進歩に対する重要かつ根本的なボトルネックを表しています。ツールの量を最大化するという初期戦略は誤りであることが証明され、パフォーマンスの低下、信頼性の低下、そして貧弱なユーザーエクスペリエンスにつながりました。学術研究と広範な開発者の議論の両方からの証拠は、明確なコンセンサスを示しています:ツール入力の生のスケールアップはアーキテクチャ上の行き止まりです。

マッキンゼーのエージェント型AIに関するレポートが指摘するように、スケーリングには、増大する技術的負債と新しいクラスのリスクを管理するための新しい「エージェント型AIメッシュ」—モジュール式で回復力のあるアーキテクチャ—が必要です。(出典). 前進する道は、利用可能なツールの数を制限することではなく、それらを管理するためのより洗練されたアーキテクチャを開発することにあります。エージェント型AIの未来は、コンテキストをインテリジェントかつ動的に管理できるシステムにかかっています。サーバーサイドの抽象化を通じてであれ、クライアントサイドの動的フィルタリングを通じてであれ、次世代のAIエージェントは、広大な潜在的ツールの海を精度と集中力をもって航行できなければなりません。このツーリングのボトルネックを克服することは、機能的に限定されたAIから真にスケーラブルでインテリジェントなエージェント型システムへの進化における必要不可欠なステップです。