Le Goulot d'Étranglement de l'Outillage : Un Aperçu du Problème de Surcharge d'Outils en IA/MCP

1. Introduction : Le Paradoxe de la Capacité

Le paradigme opérationnel de l'IA agentique est centré sur la capacité du modèle à sélectionner et à utiliser une suite d'outils externes — de la gestion de calendrier et des clients de messagerie aux requêtes de bases de données complexes et aux API de recherche web. L'objectif est de créer un assistant polyvalent capable d'exécuter des tâches complexes du monde réel en plusieurs étapes. L'hypothèse logique, mais erronée, a été qu'un plus grand ensemble d'outils équivaut à un agent plus puissant.

En pratique, un problème critique de mise à l'échelle est apparu. À mesure que le nombre d'outils disponibles augmente, les performances du Grand Modèle de Langage (LLM) sous-jacent ne s'adaptent pas de manière linéaire. Au lieu de cela, il entre dans un état de dégradation caractérisé par une précision réduite dans la sélection des outils, des taux d'échec de tâches accrus et des coûts opérationnels plus élevés. Cette « surcharge d'outils » n'est pas un problème périphérique mais un défi fondamental à l'approche actuelle de la construction de systèmes agentiques. Comme l'a exprimé un développeur sur Hacker News dans une discussion sur le Model Context Protocol (MCP), une norme pour l'intégration d'outils, le problème est fondamental : « Mon point est que l'ajout de plus en plus d'outils ne s'adapte pas et ne fonctionne pas. Cela ne fonctionne que lorsque vous avez quelques outils. Si vous avez 50 serveurs MCP activés, vos requêtes sont probablement dégradées. » (Source).

Ce phénomène crée un sentiment tangible de frustration. Les développeurs et même les utilisateurs occasionnels se sentent dépassés, un utilisateur de Reddit décrivant son expérience avec plusieurs outils d'IA comme « chaotique » et perdant le fil de « quel outil j'ai utilisé pour quoi ». (

). Cet article déconstruira ce problème d'un point de vue technique, étayé par des preuves issues de la recherche universitaire et des forums de développeurs, pour formaliser le goulot d'étranglement de l'outillage comme un obstacle principal pour l'avenir de l'IA.2. Fondements Techniques du Problème de Surcharge d'Outils

Le problème de la surcharge d'outils découle des limitations architecturales des LLM contemporains, principalement liées à leurs fenêtres de contexte finies et à leurs mécanismes d'attention. Bien que les fenêtres de contexte se soient considérablement élargies, les méthodes pour utiliser cet espace n'ont pas suivi, entraînant d'importants compromis de performance.

2.1. Gonflement de la Fenêtre de Contexte et Dégradation du Raisonnement

La capacité d'un LLM à utiliser un outil dépend de la présence de la définition de cet outil dans sa fenêtre de contexte — la mémoire à court terme effective du modèle. Cette définition inclut le nom de l'outil, une description en langage naturel de sa fonction et ses paramètres. À mesure que de nouveaux outils sont ajoutés, la taille globale de ces définitions, ou « gonflement des jetons », consomme une part de plus en plus importante de la fenêtre de contexte.

Cela a deux conséquences négatives. Premièrement, cela augmente directement le coût de calcul et la latence de chaque requête. Comme le démontre une recherche de Meibel AI, il existe une corrélation directe entre le nombre de jetons d'entrée et le temps nécessaire pour générer un jeton de sortie. (Source). Deuxièmement, et de manière plus critique, cela évince l'espace disponible pour le contexte réel spécifique à la tâche. Cela inclut les instructions de l'utilisateur, l'historique de la conversation et les « pensées » intermédiaires dont le modèle a besoin pour raisonner sur un problème. Comme le note Sean Blanchfield dans son analyse, « Le Piège des Outils MCP », cela force un compromis entre fournir des descriptions d'outils détaillées (pour la précision) et laisser suffisamment d'espace pour le processus de raisonnement du modèle.

2.2. Précision Diminuée et le Problème du « Perdu au Milieu »

Lorsqu'un LLM est confronté à un vaste ensemble d'outils, sa capacité à sélectionner le bon pour une tâche donnée se détériore. Le mécanisme d'« attention » du modèle doit évaluer un plus grand nombre de possibilités, ce qui augmente la probabilité d'erreur. Ceci est aggravé par le phénomène du « perdu au milieu », où les modèles montrent de meilleures performances pour se souvenir des informations placées au début ou à la fin de la fenêtre de contexte, tandis que les informations au milieu sont souvent ignorées ou mal mémorisées.

Cela peut se manifester par :

- Sélection d'Outil Incorrecte : Choisir un outil fonctionnellement inapproprié pour la tâche.

- Hallucination de Paramètres : Invoquer le bon outil mais avec des paramètres inventés ou incorrects.

- Interférence d'Outils : Les descriptions d'outils aux noms similaires ou aux fonctions qui se chevauchent peuvent « embrouiller » le modèle, entraînant un comportement imprévisible.

Ce phénomène est soutenu empiriquement. L'article de recherche « Moins c'est Plus : Sur la Sélection d'Outils pour les Grands Modèles de Langage » démontre une corrélation négative claire entre le nombre d'outils disponibles et la précision de l'appel d'outils. Un développeur sur le subreddit r/AI_Agents corrobore cela d'un point de vue pratique : « [une fois qu'un agent a accès à plus de 5 outils... la précision chute. L'enchaînement de plusieurs appels d'outils devient peu fiable.] » (

).

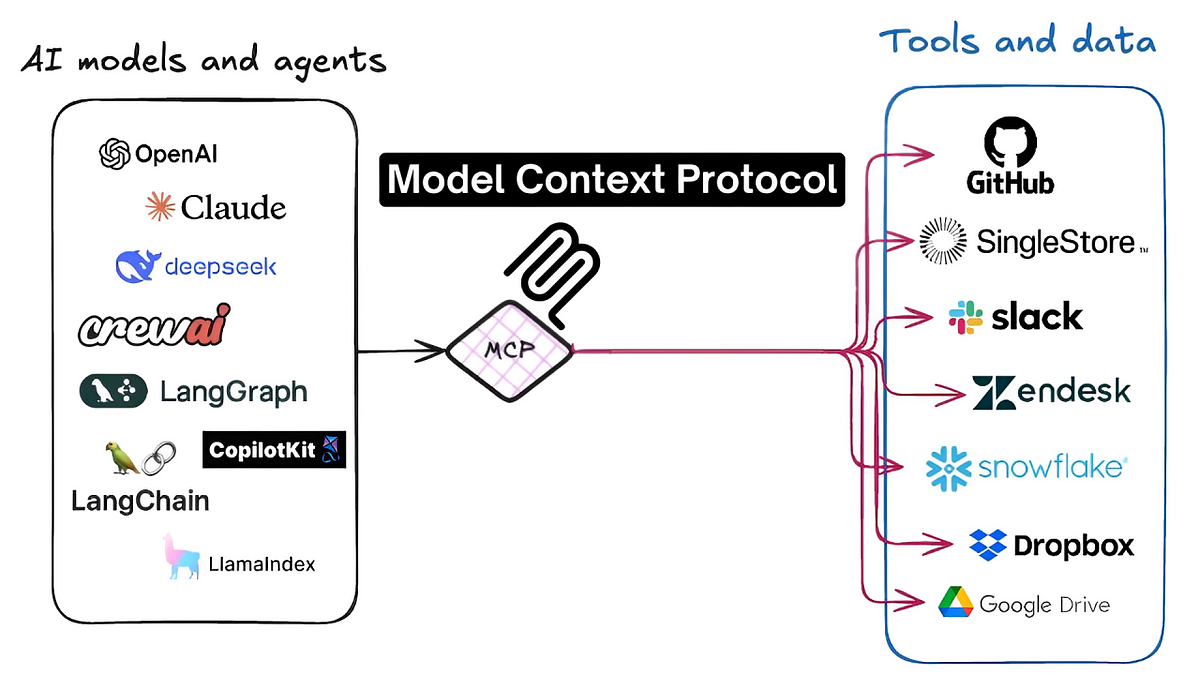

3. Étude de Cas : L'Écosystème du Model Context Protocol (MCP)

Le problème de la surcharge d'outils est particulièrement aigu au sein de l'écosystème MCP. Le MCP est un protocole standardisé conçu pour faciliter une interaction transparente entre les agents d'IA et des milliers d'outils tiers (serveurs MCP). Bien que cette norme ait catalysé l'innovation, elle est également devenue un point central du problème de mise à l'échelle.

La conception même du MCP, qui repose sur des définitions d'outils découvrables en langage naturel, expose directement les agents aux problèmes de gonflement de la fenêtre de contexte et de déficit d'attention. La tentation pour les utilisateurs et les développeurs est d'activer un grand nombre de serveurs MCP pour maximiser les capacités potentielles d'un agent. Cependant, comme l'a déclaré avec force un commentateur de Hacker News, cette approche est fondamentalement erronée :

« Le MCP ne s'adapte pas. Il ne peut pas s'adapter au-delà d'un certain seuil. Il est impossible d'ajouter un nombre illimité d'outils au contexte de vos agents sans nuire à la capacité de votre agent. C'est une limitation fondamentale de tout le concept du MCP... Vous verrez des publications comme « Le MCP était bon avant mais maintenant… » à mesure que les gens ressentent les effets d'avoir de nombreux serveurs MCP activés. Ils interfèrent les uns avec les autres. » (Source)

Cela souligne que le problème n'est pas simplement un détail d'implémentation mais un défi architectural inhérent à l'approche actuelle du « tout charger ». Une autre discussion a souligné que le goulot d'étranglement réside dans les modèles eux-mêmes, qui « ont du mal lorsque vous leur donnez trop d'outils à appeler. Ils sont mauvais pour évaluer le bon outil à utiliser lorsqu'on leur donne des outils avec des fonctionnalités qui se chevauchent ou des noms/arguments de fonction similaires. » (Source). Le consensus dans ces communautés techniques est que sans solution, la promesse d'un vaste écosystème d'outils interconnectés via le MCP restera lettre morte, limitée par la capacité cognitive des modèles mêmes qu'il cherche à renforcer.

4. Architectures de Solution Proposées

L'industrie converge vers deux approches principales pour atténuer le problème de la surcharge d'outils. Ces solutions visent à s'éloigner de la méthode naïve consistant à charger tous les outils disponibles dans la fenêtre de contexte pour chaque tâche, une pratique qui s'est avérée inefficace et sujette aux erreurs.

4.1. Solutions Côté Serveur : Abstraction et Hiérarchies d'Outils

Cette approche se concentre sur le fait de rendre les serveurs d'outils eux-mêmes plus intelligents. Au lieu d'exposer un grand nombre d'outils granulaires de bas niveau à l'agent, une solution côté serveur peut les abstraire en capacités composites de plus haut niveau. Cela réduit le nombre de choix que le LLM doit faire à un moment donné.

Un exemple de ceci est le concept de « strata » proposé par Klavis AI. Selon leur documentation API, ce système permet la création dynamique de hiérarchies d'outils. Cela pourrait permettre à un agent de sélectionner d'abord une catégorie large (par exemple, « gestion de fichiers ») et de ne se voir présenter ensuite qu'un sous-ensemble plus petit et plus pertinent d'outils (par exemple, « créer_fichier », « mettre_à_jour_fichier »), réduisant ainsi la charge cognitive sur le modèle à chaque étape.

4.2. Solutions Côté Client : Sélection et Filtrage Dynamiques d'Outils

Cette approche place l'intelligence au sein de l'application client qui orchestre l'agent d'IA. L'idée centrale est de mettre en œuvre une couche de prétraitement ou de routage qui analyse l'intention de l'utilisateur avant d'engager le LLM principal. Cette couche est responsable de la sélection dynamique d'un petit sous-ensemble très pertinent d'outils à partir d'une bibliothèque beaucoup plus grande et d'injecter uniquement ceux-ci dans la fenêtre de contexte pour la tâche spécifique en cours.

Un exemple de ceci est l'approche adoptée par Jenova, qui utilise un système intermédiaire qui filtre et classe intelligemment les outils disponibles en fonction de la demande en langage naturel de l'utilisateur. Comme détaillé dans l'analyse trouvée dans « Le Goulot d'Étranglement de l'Outillage », cette méthode crée un ensemble d'outils « juste à temps » pour le LLM. Ce faisant, elle maintient la fenêtre de contexte légère et ciblée, préservant ainsi la capacité de raisonnement du modèle et améliorant considérablement la précision de la sélection des outils. Cela correspond aux idées de Memgraph, qui soutient que la clé est de « fournir aux LLM le bon contexte, au bon moment, de manière structurée », plutôt que de simplement construire des modèles plus grands. (Source).

5. Conclusion : Vers des Architectures Agentiques Évolutives

Le problème de la surcharge d'outils représente un goulot d'étranglement significatif et fondamental pour l'avancement d'agents d'IA capables et polyvalents. La stratégie initiale de maximisation de la quantité d'outils s'est avérée être une erreur, entraînant une dégradation des performances, une fiabilité réduite et une mauvaise expérience utilisateur. Les preuves issues de la recherche universitaire et des discussions approfondies entre développeurs indiquent un consensus clair : la mise à l'échelle brute des entrées d'outils est une impasse architecturale.

Comme le note un rapport de McKinsey sur l'IA agentique, la mise à l'échelle nécessite un nouveau « maillage d'IA agentique » — une architecture modulaire et résiliente — pour gérer la dette technique croissante et les nouvelles classes de risques. (Source). La voie à suivre ne consiste pas à limiter le nombre d'outils disponibles, mais à développer des architectures plus sophistiquées pour les gérer. L'avenir de l'IA agentique dépendra de systèmes capables de gérer intelligemment et dynamiquement le contexte. Que ce soit par l'abstraction côté serveur ou le filtrage dynamique côté client, la prochaine génération d'agents d'IA devra être capable de naviguer dans un vaste océan d'outils potentiels avec précision et concentration. Surmonter ce goulot d'étranglement de l'outillage est une étape nécessaire et critique dans l'évolution d'une IA fonctionnellement limitée vers des systèmes agentiques véritablement évolutifs et intelligents.