Der Tooling-Engpass: Ein Überblick über das Problem der Tool-Überlastung bei KI/MCP

1. Einleitung: Das Paradox der Fähigkeit

Das operative Paradigma für agentenbasierte KI konzentriert sich auf die Fähigkeit des Modells, eine Reihe externer Tools auszuwählen und zu nutzen – von Kalenderverwaltung und E-Mail-Clients bis hin zu komplexen Datenbankabfragen und Web-Such-APIs. Das Ziel ist es, einen vielseitigen Assistenten zu schaffen, der in der Lage ist, mehrstufige, reale Aufgaben auszuführen. Die logische, aber fehlerhafte Annahme war, dass ein größerer Werkzeugsatz einem leistungsfähigeren Agenten gleichkommt.

In der Praxis hat sich ein kritisches Skalierungsproblem herauskristallisiert. Mit zunehmender Anzahl verfügbarer Tools skaliert die Leistung des zugrunde liegenden Large Language Model (LLM) nicht linear. Stattdessen tritt ein Zustand der Verschlechterung ein, der durch eine verringerte Genauigkeit bei der Werkzeugauswahl, erhöhte Aufgabenfehlerraten und höhere Betriebskosten gekennzeichnet ist. Diese „Tool-Überlastung“ ist kein nebensächliches Problem, sondern eine grundlegende Herausforderung für den aktuellen Ansatz zum Aufbau agentenbasierter Systeme. Wie ein Entwickler auf Hacker News in einer Diskussion über das Model Context Protocol (MCP), einen Standard für die Tool-Integration, formulierte, ist das Problem fundamental: „Mein Punkt ist, dass das Hinzufügen von immer mehr und mehr Tools nicht skaliert und nicht funktioniert. Es funktioniert nur, wenn man wenige Tools hat. Wenn Sie 50 MCP-Server aktiviert haben, sind Ihre Anfragen wahrscheinlich beeinträchtigt.“ (Quelle).

Dieses Phänomen erzeugt ein spürbares Gefühl der Frustration. Entwickler und sogar Gelegenheitsnutzer berichten, dass sie sich überfordert fühlen. Ein Reddit-Benutzer beschrieb seine Erfahrung mit mehreren KI-Tools als „chaotisch“ und dass er den Überblick verliere, „welches Tool ich wofür verwendet habe“. (

). Dieser Artikel wird dieses Problem aus technischer Sicht dekonstruieren, gestützt auf Erkenntnisse aus akademischer Forschung und Entwicklerforen, um den Tooling-Engpass als primäres Hindernis für die Zukunft der KI zu formalisieren.2. Technische Grundlagen des Tool-Überlastungsproblems

Das Problem der Tool-Überlastung ergibt sich aus den architektonischen Einschränkungen moderner LLMs, die hauptsächlich mit ihren endlichen Kontextfenstern und Aufmerksamkeitsmechanismen zusammenhängen. Obwohl die Kontextfenster dramatisch erweitert wurden, haben die Methoden zur Nutzung dieses Raums nicht Schritt gehalten, was zu erheblichen Leistungseinbußen führt.

2.1. Aufblähung des Kontextfensters und Verschlechterung des logischen Denkens

Die Fähigkeit eines LLM, ein Tool zu verwenden, hängt davon ab, dass die Definition dieses Tools in seinem Kontextfenster – dem effektiven Kurzzeitgedächtnis des Modells – vorhanden ist. Diese Definition umfasst den Namen des Tools, eine natürlichsprachliche Beschreibung seiner Funktion und seine Parameter. Wenn mehr Tools hinzugefügt werden, verbraucht die Gesamtgröße dieser Definitionen, oder „Token-Bloat“, einen immer größeren Teil des Kontextfensters.

Dies hat zwei negative Konsequenzen. Erstens erhöht es direkt die Rechenkosten und die Latenz jeder Anfrage. Wie Untersuchungen von Meibel AI zeigen, gibt es eine direkte Korrelation zwischen der Anzahl der Eingabe-Token und der Zeit, die zur Generierung eines Ausgabe-Tokens benötigt wird. (Quelle). Zweitens, und noch kritischer, verdrängt es den für den eigentlichen aufgabenspezifischen Kontext verfügbaren Platz. Dazu gehören die Anweisungen des Benutzers, der Gesprächsverlauf und die zwischengeschalteten „Gedanken“, die das Modell benötigt, um ein Problem zu durchdenken. Wie Sean Blanchfield in seiner Analyse „The MCP Tool Trap“ feststellt, erzwingt dies einen Kompromiss zwischen der Bereitstellung detaillierter Tool-Beschreibungen (für die Genauigkeit) und dem Belassen von ausreichend Platz für den Denkprozess des Modells.

2.2. Verminderte Genauigkeit und das „Lost in the Middle“-Problem

Wenn einem LLM eine umfangreiche Auswahl an Tools präsentiert wird, verschlechtert sich seine Fähigkeit, das richtige für eine bestimmte Aufgabe auszuwählen. Der „Aufmerksamkeits“-Mechanismus des Modells muss eine größere Anzahl von Möglichkeiten bewerten, was die Fehlerwahrscheinlichkeit erhöht. Dies wird durch das „Lost in the Middle“-Phänomen verschärft, bei dem Modelle eine bessere Leistung beim Abrufen von Informationen zeigen, die am Anfang oder Ende des Kontextfensters platziert sind, während Informationen in der Mitte oft ignoriert oder falsch erinnert werden.

Dies kann sich äußern als:

- Falsche Werkzeugauswahl: Auswahl eines Werkzeugs, das für die Aufgabe funktionell ungeeignet ist.

- Parameter-Halluzination: Aufrufen des richtigen Werkzeugs, aber mit erfundenen oder falschen Parametern.

- Werkzeug-Interferenz: Beschreibungen von ähnlich benannten oder sich funktionell überschneidenden Werkzeugen können das Modell „verwirren“, was zu unvorhersehbarem Verhalten führt.

Dieses Phänomen ist empirisch belegt. Die Forschungsarbeit „Less is More: On the Selection of Tools for Large Language Models“ zeigt eine klare negative Korrelation zwischen der Anzahl der verfügbaren Tools und der Genauigkeit des Tool-Aufrufs. Ein Entwickler im r/AI_Agents-Subreddit bestätigt dies aus praktischer Sicht: „[sobald ein Agent Zugriff auf 5+ Tools hat... sinkt die Genauigkeit. Die Verkettung mehrerer Tool-Aufrufe wird unzuverlässig.]“ (

).

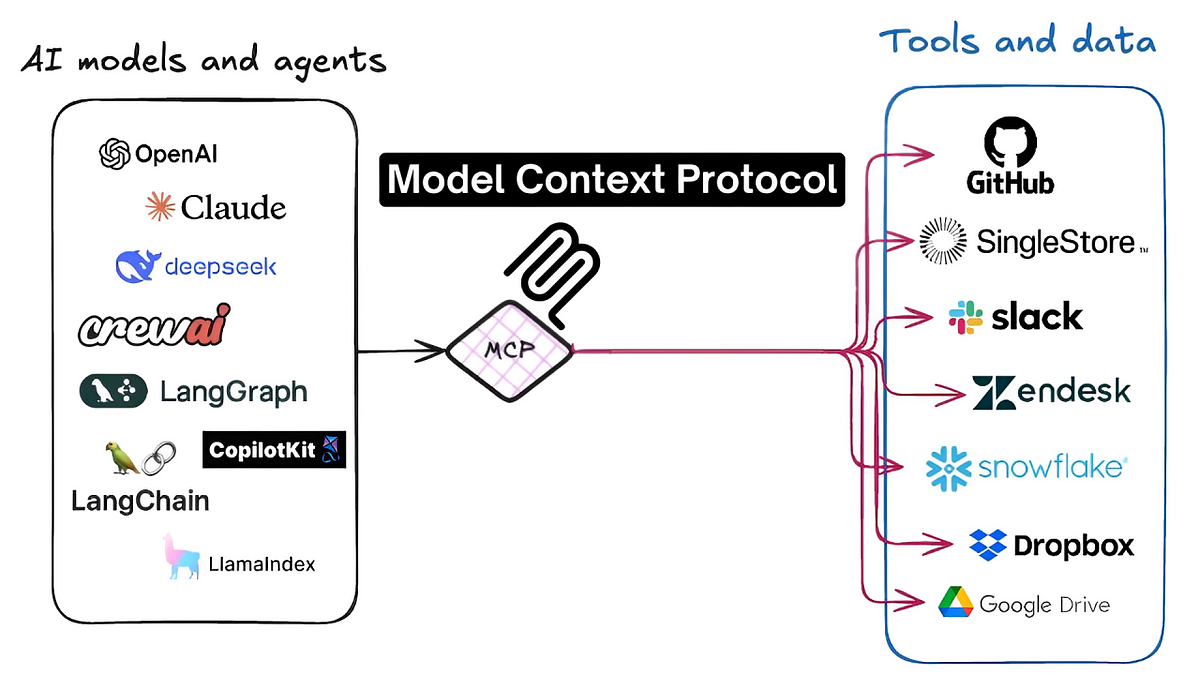

3. Fallstudie: Das Ökosystem des Model Context Protocol (MCP)

Das Problem der Tool-Überlastung ist im MCP-Ökosystem besonders akut. MCP ist ein standardisiertes Protokoll, das die nahtlose Interaktion zwischen KI-Agenten und Tausenden von Drittanbieter-Tools (MCP-Servern) erleichtern soll. Obwohl dieser Standard Innovationen katalysiert hat, ist er auch zu einem Brennpunkt für das Skalierungsproblem geworden.

Gerade das Design von MCP, das auf auffindbaren, natürlichsprachlichen Tool-Definitionen beruht, setzt Agenten direkt den Problemen der Kontextfenster-Aufblähung und des Aufmerksamkeitsdefizits aus. Die Versuchung für Benutzer und Entwickler besteht darin, eine große Anzahl von MCP-Servern zu aktivieren, um die potenziellen Fähigkeiten eines Agenten zu maximieren. Wie ein Kommentator auf Hacker News jedoch eindringlich feststellte, ist dieser Ansatz grundlegend fehlerhaft:

„MCP skaliert nicht. Es kann nicht über eine bestimmte Schwelle hinaus skalieren. Es ist unmöglich, eine unbegrenzte Anzahl von Tools zum Kontext Ihrer Agenten hinzuzufügen, ohne die Fähigkeit Ihres Agenten negativ zu beeinflussen. Dies ist eine grundlegende Einschränkung des gesamten Konzepts von MCP... Sie werden Beiträge wie „MCP war früher gut, aber jetzt…“ sehen, wenn die Leute die Auswirkungen von vielen aktivierten MCP-Servern erleben. Sie stören sich gegenseitig.“ (Quelle)

Dies unterstreicht, dass das Problem nicht nur ein Implementierungsdetail ist, sondern eine architektonische Herausforderung, die dem aktuellen „Alles laden“-Ansatz innewohnt. Eine andere Diskussion wies darauf hin, dass der Engpass die Modelle selbst sind, die „Schwierigkeiten haben, wenn man ihnen zu viele Tools zum Aufrufen gibt. Sie sind schlecht darin, das richtige Tool zu bewerten, wenn sie Tools mit überlappender Funktionalität oder ähnlichen Funktionsnamen/Argumenten erhalten.“ (Quelle). Der Konsens in diesen technischen Gemeinschaften ist, dass ohne eine Lösung das Versprechen eines riesigen, vernetzten Tool-Ökosystems über MCP unerfüllt bleiben wird, begrenzt durch die kognitive Kapazität eben jener Modelle, die es zu stärken sucht.

4. Vorgeschlagene Lösungsarchitekturen

Die Branche konvergiert auf zwei primäre Ansätze zur Minderung des Tool-Überlastungsproblems. Diese Lösungen zielen darauf ab, von der naiven Methode abzuweichen, alle verfügbaren Tools für jede Aufgabe in das Kontextfenster zu laden, eine Praxis, die sich als ineffizient und fehleranfällig erwiesen hat.

4.1. Serverseitige Lösungen: Tool-Abstraktion und Hierarchien

Dieser Ansatz konzentriert sich darauf, die Tool-Server selbst intelligenter zu machen. Anstatt dem Agenten eine große Anzahl granularer, untergeordneter Tools zur Verfügung zu stellen, kann eine serverseitige Lösung sie in übergeordnete, zusammengesetzte Fähigkeiten abstrahieren. Dies reduziert die Anzahl der Entscheidungen, die das LLM zu einem bestimmten Zeitpunkt treffen muss.

Ein Beispiel hierfür ist das von Klavis AI vorgeschlagene „Strata“-Konzept. Laut ihrer API-Dokumentation ermöglicht dieses System die dynamische Erstellung von Tool-Hierarchien. Dies könnte es einem Agenten ermöglichen, zuerst eine breite Kategorie (z. B. „Dateiverwaltung“) auszuwählen und erst dann eine kleinere, relevantere Untergruppe von Tools (z. B. „create_file“, „update_file“) präsentiert zu bekommen, wodurch die kognitive Belastung des Modells bei jedem Schritt reduziert wird.

4.2. Clientseitige Lösungen: Dynamische Tool-Auswahl und Filterung

Dieser Ansatz verlagert die Intelligenz in die Client-Anwendung, die den KI-Agenten orchestriert. Die Kernidee ist die Implementierung einer Vorverarbeitungs- oder Routing-Schicht, die die Absicht des Benutzers analysiert, bevor das primäre LLM einbezogen wird. Diese Schicht ist dafür verantwortlich, dynamisch eine kleine, hochrelevante Untergruppe von Tools aus einer viel größeren Bibliothek auszuwählen und nur diese für die spezifische Aufgabe in das Kontextfenster zu injizieren.

Ein Beispiel hierfür ist der Ansatz von Jenova, das ein zwischengeschaltetes System verwendet, das verfügbare Tools basierend auf der natürlichsprachlichen Anfrage des Benutzers intelligent filtert und einstuft. Wie in der Analyse in „The Tooling Bottleneck“ detailliert beschrieben, erstellt diese Methode ein „Just-in-Time“-Toolset für das LLM. Dadurch bleibt das Kontextfenster schlank und fokussiert, wodurch die Denkfähigkeit des Modells erhalten und die Genauigkeit der Werkzeugauswahl drastisch verbessert wird. Dies steht im Einklang mit den Erkenntnissen von Memgraph, die argumentieren, dass der Schlüssel darin liegt, „LLMs den richtigen Kontext zur richtigen Zeit auf strukturierte Weise zuzuführen“, anstatt einfach größere Modelle zu bauen. (Quelle).

5. Fazit: Auf dem Weg zu skalierbaren agentenbasierten Architekturen

Das Problem der Tool-Überlastung stellt einen signifikanten und fundamentalen Engpass für die Weiterentwicklung fähiger, universell einsetzbarer KI-Agenten dar. Die anfängliche Strategie, die Werkzeugquantität zu maximieren, hat sich als Trugschluss erwiesen und führt zu Leistungseinbußen, verringerter Zuverlässigkeit und einer schlechten Benutzererfahrung. Die Erkenntnisse aus akademischer Forschung und umfangreichen Entwicklerdiskussionen deuten auf einen klaren Konsens hin: Die rohe Skalierung von Tool-Eingaben ist eine architektonische Sackgasse.

Wie ein McKinsey-Bericht über agentenbasierte KI feststellt, erfordert die Skalierung ein neues „agentenbasiertes KI-Mesh“ – eine modulare und widerstandsfähige Architektur – um die zunehmende technische Verschuldung und neue Risikoklassen zu bewältigen. (Quelle). Der Weg nach vorne liegt nicht darin, die Anzahl der verfügbaren Tools zu begrenzen, sondern darin, anspruchsvollere Architekturen für deren Verwaltung zu entwickeln. Die Zukunft der agentenbasierten KI wird von Systemen abhängen, die den Kontext intelligent und dynamisch verwalten können. Ob durch serverseitige Abstraktion oder clientseitige dynamische Filterung, die nächste Generation von KI-Agenten muss in der Lage sein, mit Präzision und Fokus durch einen riesigen Ozean potenzieller Tools zu navigieren. Die Überwindung dieses Tooling-Engpasses ist ein notwendiger und entscheidender Schritt in der Entwicklung von funktionell begrenzter KI hin zu wirklich skalierbaren und intelligenten agentenbasierten Systemen.