本地 MCP 服务器 AI:兼顾隐私与性能,扩展 AI 工具

2025-07-17

本地 MCP 服务器通过直接在您的机器上运行,改变了 AI 应用与您的数据和工具交互的方式。与通过互联网传输敏感信息的云端解决方案不同,本地服务器在设备上处理所有内容,确保了完全的隐私,同时提供近乎即时的性能。

主要优势:

- ✅ 零数据传输至外部服务器

- ✅ 通过直接通信实现亚毫秒级响应时间

- ✅ 完全离线功能,不依赖互联网

- ✅ 为任何本地工作流提供无限定制

要理解为什么这种架构至关重要,让我们来看看当今构建 AI 驱动应用的开发者和组织所面临的挑战。

快速解答:什么是本地 MCP 服务器?

本地 MCP 服务器是在您的计算机上运行的程序,通过提供对本地文件、数据库和应用的安全、直接访问来扩展 AI 的能力。 它们使用 Model Context Protocol (MCP) 标准向 AI 客户端暴露工具和数据源,而无需通过互联网发送信息。

主要能力:

- 完全在设备上处理敏感数据,实现最大程度的隐私保护

- 使 AI 能够与本地文件、代码库和应用进行交互

- 通过直接的进程间通信提供实时性能

- 完全离线运行,不依赖云服务

问题所在:AI 工具需要安全的本地访问权限

随着 AI 助手变得越来越复杂,它们需要与用户的个人环境进行更深度的集成。然而,这带来了根本性的挑战:

73% 的开发者 对 AI 工具访问其专有代码库和敏感数据表示担忧。

AI 采纳的关键障碍:

- 隐私风险 – 将敏感文件和数据传输到云服务

- 网络延迟 – 与远程服务器的往返通信造成的延迟

- 连接要求 – 依赖稳定的互联网连接

- 有限的定制性 – 无法与专门的本地工具集成

- 数据治理 – 遵守企业安全策略的合规性挑战

隐私与安全顾虑

当 AI 工具需要云连接时,每一次文件访问、数据库查询或代码片段都必须传输到外部服务器。对于处理专有代码或受监管数据的企业来说,这带来了不可接受的风险。

445 万美元 – 根据 IBM Security 的数据,2023 年数据泄露的平均成本。

受 GDPR、HIPAA 或其他数据保护法规约束的组织,在使用基于云的 AI 服务时面临额外的合规负担。即使有加密,将数据传输到外部的行为本身也常常违反内部安全策略。

性能瓶颈

基于云的 AI 工具在每次交互中都会引入延迟。一个在本地只需几微秒的简单文件读取操作,在通过远程服务器路由时可能需要 100-500 毫秒。

200-300 毫秒 – 根据 Cloudflare 的数据,云 API 调用的典型往返延迟。

对于交互式工作流——如代码补全、实时调试或快速文件搜索——这种延迟会迅速累积,降低用户体验和生产力。

离线限制

依赖云的 AI 工具在没有互联网连接的情况下会完全无法使用。在飞机上、偏远地区或网络中断期间工作的开发者,恰恰在替代资源也有限的情况下,失去了关键的 AI 辅助。

解决方案:用于安全 AI 扩展的本地 MCP 服务器

本地 MCP 服务器通过直接在您的机器上运行来解决这些挑战,在 AI 客户端和您的本地环境之间建立了一座安全的桥梁。Model Context Protocol 为这种集成提供了标准化的架构。

| 传统云 AI | 本地 MCP 服务器 |

|---|---|

| 数据传输至外部服务器 | 所有处理均在设备上完成 |

| 200-500 毫秒网络延迟 | 亚毫秒级响应时间 |

| 需要互联网连接 | 完全离线功能 |

| 仅限于预构建的集成 | 无限创建自定义工具 |

| 第三方数据访问 | 用户控制的权限 |

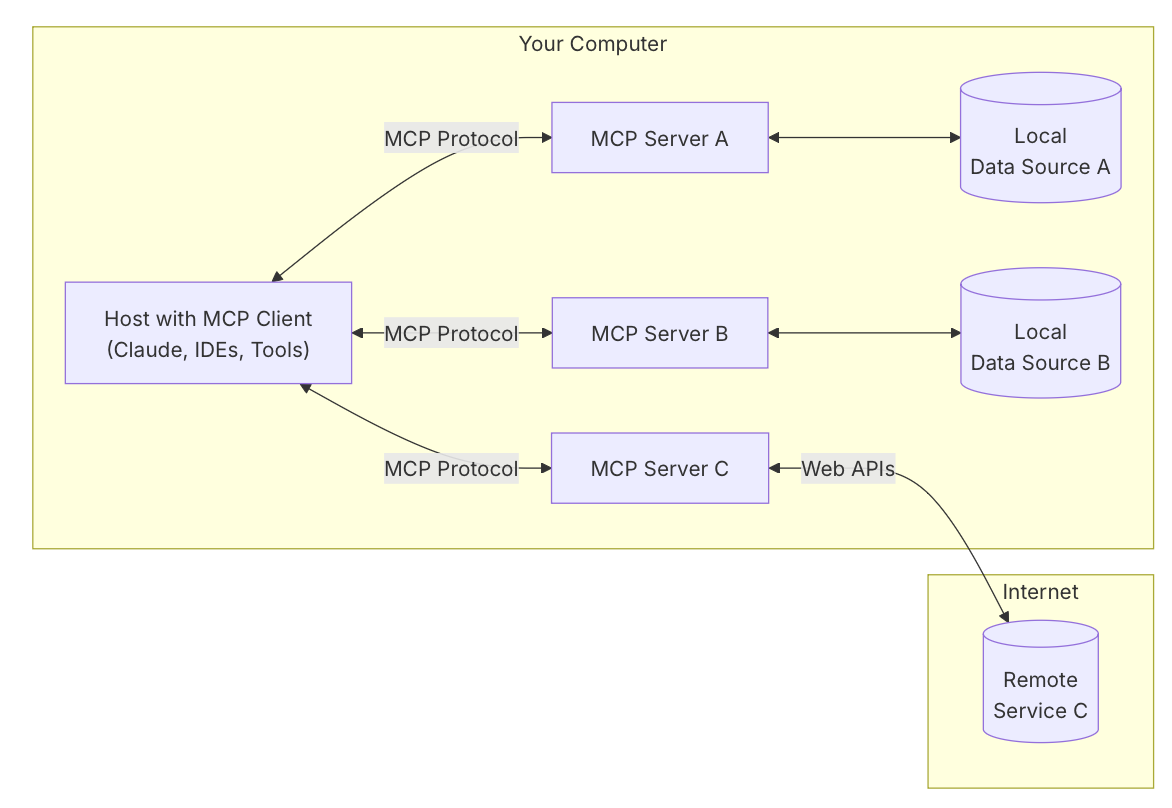

理解 MCP 架构

Model Context Protocol 采用三组件模型运行:

宿主应用 (Host Application) 用户与之交互的主要 AI 驱动应用——例如 AI 聊天助手、代码编辑器或桌面智能体。用户在这里发出请求并接收响应。

MCP 客户端 (MCP Client) 嵌入在宿主应用中,客户端处理协议通信。它从连接的服务器发现可用工具,将用户请求转换为工具调用,并管理执行流程。

MCP 服务器 (MCP Server) 一个通过标准化接口暴露特定功能的独立程序。在本地设置中,服务器在同一台机器上运行,并通过标准输入/输出 (stdio) 进行通信——这是一种直接的进程间通信方法,消除了网络开销。

隐私优先的架构

本地服务器确保敏感数据永远不会离开您的机器。当 AI 需要访问私有代码库、个人文件或本地数据库时,服务器完全在设备上处理请求。没有任何信息会传输到外部服务。

所有操作都需要通过宿主应用获得用户的明确批准。用户完全控制 AI 可以访问、修改或执行的内容,从而创建了一个与云端替代方案根本不同的信任模型。

通过直接通信实现高性能

通过使用 stdio 进行进程间通信,本地服务器实现了以微秒而非毫秒计的响应时间。这种直接连接消除了:

- 网络序列化/反序列化开销

- TLS 握手延迟

- 互联网路由延迟

- API 速率限制

- 服务器队列等待时间

对于涉及频繁、小型交互的工作流——如代码分析、文件导航或实时数据查找——这种性能差异改变了用户体验。

离线优先的能力

本地服务器独立于互联网连接运行。AI 助手可以在飞行途中、连接不良的地区或网络中断期间继续提供价值。这种可靠性使得 AI 驱动的工具在无法保证连接的关键任务工作流中变得可行。

本地 MCP 服务器如何工作:分步指南

无论您是使用现有服务器还是构建自定义解决方案,实现本地 MCP 服务器都遵循一个简单的过程。

第 1 步:安装 MCP 服务器

为您的用例下载或构建服务器程序。Awesome MCP Servers 仓库为常见任务(如文件系统访问、Git 集成或数据库连接)提供了数十个预构建选项。对于自定义需求,请使用 Python、Node.js 或 C# 的官方 SDK。

第 2 步:配置宿主应用

将服务器添加到您的 AI 客户端的配置文件中(通常是 JSON 格式)。指定服务器可执行文件路径和任何必需的参数。例如,一个文件系统服务器的配置可能如下所示:

json{

"mcpServers": {

"filesystem": {

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-filesystem", "/Users/username/Documents"]

}

}

}

第 3 步:启动并连接

当您启动宿主应用时,它会自动将配置的服务器作为子进程启动。客户端建立 stdio 通信渠道并执行握手以发现可用的工具和功能。

第 4 步:授予权限

当 AI 尝试使用服务器工具时,宿主应用会提示用户批准。在授予权限之前,您可以确切地审查 AI 想要执行的操作——读取特定文件、执行命令或查询数据库。

第 5 步:执行 AI 驱动的工作流

在服务器连接并获得权限后,您可以使用自然语言来完成复杂的任务。要求 AI “在我项目中查找所有 TODO 注释”、“创建一个新的 React 组件”或“查询本地数据库以获取最近的交易”——AI 将通过连接的服务器协调必要的工具调用。

真实世界的应用和用例

本地 MCP 服务器在开发、研究和个人生产力领域实现了复杂的 AI 工作流。

💻 软件开发和代码管理

场景: 一位开发者需要重构一个大型代码库,同时保持数百个文件的一致性。

传统方法: 手动搜索模式,逐个更新文件,运行测试,并修复破坏性更改——需要数小时的专注工作。

使用本地 MCP 服务器: AI 使用文件系统服务器扫描整个代码库,识别所有需要更改的实例,提出修改建议,并同时在多个文件中执行更新。一个 Git 服务器会用描述性消息提交更改。

主要优势:

- 通过语言服务器集成实现语义代码理解

- 跨整个项目进行自动化重构

- 通过 Git 集成实现即时回滚,安全进行实验

- 专有代码暴露风险为零

根据 WorkOS 对 MCP 架构的分析,使用本地服务器进行代码辅助的开发者报告称,复杂重构任务的完成时间加快了 40-60%。

📊 本地数据库分析和管理

场景: 一位数据分析师需要探索本地 PostgreSQL 数据库,理解模式关系,并生成报告。

传统方法: 手动编写 SQL 查询,将结果导出到电子表格,单独创建可视化——这是一个需要多种工具的碎片化工作流。

使用本地 MCP 服务器: AI 通过 MCP 服务器连接到本地数据库,探索模式,根据自然语言请求生成优化查询,并直接在对话中格式化结果。

主要优势:

- 无需 SQL 专业知识即可进行自然语言数据库查询

- 自动模式探索和关系映射

- 敏感数据完全保留在设备上

- 通过 AI 辅助简化复杂的多表连接

📱 移动开发和测试

场景: 一位移动开发者需要在多种设备配置和屏幕尺寸上测试一个 iOS 应用。

传统方法: 手动启动模拟器,浏览应用流程,捕获屏幕截图,并记录问题——重复且耗时。

使用本地 MCP 服务器: 一个 iOS 模拟器服务器允许 AI 以编程方式控制模拟器,执行测试场景,捕获屏幕截图,并自动编译测试报告。

主要优势:

- 跨设备配置的自动化 UI 测试

- 自然语言测试用例创建

- 即时视觉回归检测

- 在多个模拟器上并行测试

🗂️ 个人知识管理

场景: 一位研究人员在各个文件夹中维护着数千份文档、论文和笔记,需要快速找到特定信息。

传统方法: 使用文件系统搜索,手动打开文档,扫描内容,并汇编发现——对于大型文档集合效率低下。

使用本地 MCP 服务器: AI 使用文件系统服务器在所有文档中进行搜索,提取相关段落,总结发现,并创建有组织的报告——所有这些都在本地保留敏感研究数据。

主要优势:

- 跨整个文档集合的语义搜索

- 自动摘要和信息提取

- 跨文档综合和连接发现

- 对机密研究的完全隐私保护

构建自定义本地 MCP 服务器

对于具备基本编程知识的开发者来说,创建自定义本地 MCP 服务器是可行的。官方 MCP 服务器快速入门指南 提供了全面的教程。

开发流程概述

选择您的 SDK 官方 SDK 支持 Python、TypeScript/Node.js 和 C#。根据您偏好的语言和需要集成的库生态系统进行选择。

定义工具函数 为您想要暴露的每个功能实现核心逻辑。例如,一个文件搜索工具可能会接受一个查询字符串,并返回匹配的文件路径和摘录。

python@server.tool()

async def search_files(query: str, directory: str) -> list[dict]:

"""Search for files containing the query string."""

results = []

for root, dirs, files in os.walk(directory):

for file in files:

# Search logic here

pass

return results

初始化服务器 使用 MCP 库创建服务器实例,注册您的工具,并配置 stdio 传输。

正确处理日志记录 由于 stdio 用于 JSON-RPC 通信,任何多余的输出都会破坏协议。将所有日志记录定向到 stderr 或单独的日志文件:

pythonimport logging

logging.basicConfig(

level=logging.INFO,

handlers=[logging.FileHandler('server.log')]

)

测试和部署 通过在兼容的宿主应用中配置您的服务器来进行测试。在分发前,验证工具发现、执行和错误处理。

安全注意事项

在构建本地服务器时,请实施适当的安全措施:

- 输入验证: 对所有参数进行清理,以防止路径遍历或命令注入。

- 权限范围限定: 将服务器访问权限限制在特定目录或资源。

- 错误处理: 提供清晰的错误消息,而不暴露系统内部信息。

- 审计日志: 记录所有操作以供安全审查。

常见问题解答

本地 MCP 服务器与基于云的 AI API 有何不同?

本地 MCP 服务器完全在您的机器上运行并在设备上处理数据,而云 API 则将数据传输到外部服务器。本地服务器提供卓越的隐私性、更低的延迟(亚毫秒级 vs. 200-500 毫秒)和离线功能。云 API 提供更强的计算能力和更容易扩展以处理资源密集型任务。最佳方法通常是两者结合:使用本地服务器处理敏感操作,使用云服务进行重度计算。

我可以在任何 AI 助手中使用本地 MCP 服务器吗?

本地 MCP 服务器可与任何实现 MCP 客户端协议的宿主应用配合使用。目前,这包括 Claude Desktop、某些 AI 增强的 IDE 以及使用 MCP SDK 构建的自定义应用。随着协议的普及,更多的 AI 工具将添加原生支持。您也可以使用官方的 MCP 客户端库构建自己的宿主应用。

使用本地 MCP 服务器需要编程知识吗?

使用预构建的服务器需要最少的技术知识——通常只需编辑一个 JSON 配置文件来指定服务器路径。构建自定义服务器需要 Python、TypeScript 或 C# 的编程技能,但官方 SDK 和文档使有基本经验的开发者也能轻松上手。Awesome MCP Servers 仓库 为常见任务提供了即用型服务器。

运行本地 MCP 服务器的性能要求是什么?

本地 MCP 服务器的开销极小,因为它们是专注于特定任务的轻量级程序。大多数服务器在空闲时消耗的 RAM 不到 50MB,CPU 占用也微不足道。性能要求取决于具体操作——文件系统服务器需要快速的磁盘 I/O,而数据库服务器则受益于足够的 RAM 用于查询缓存。过去 5-7 年内的任何现代计算机都可以同时运行多个本地服务器而不会出现性能下降。

本地 MCP 服务器对于企业使用是否安全?

本地 MCP 服务器为企业环境提供了强大的安全性,因为数据永远不会离开用户的机器。所有操作都需要通过宿主应用获得用户的明确批准。然而,组织应实施额外的控制措施:限制员工可以安装哪些服务器,审计服务器源代码以查找安全漏洞,并通过宿主应用配置强制执行权限策略。设备上的架构本身就满足了大多数数据驻留和隐私法规的要求。

本地 MCP 服务器可以与基于云的 AI 服务协同工作吗?

是的,本地和云端服务器可以在 MCP 架构内无缝协同工作。单个 AI 助手可以利用本地服务器处理敏感操作(访问私有文件、查询本地数据库),同时利用云服务器处理资源密集型任务(大规模数据处理、外部 API 集成)。这种混合方法结合了本地服务器的隐私和性能以及云基础设施的可扩展性。

结论:隐私优先的 AI 集成的未来

本地 MCP 服务器代表了 AI 应用访问和处理用户数据方式的根本性转变。通过将敏感信息保留在设备上,同时实现复杂的 AI 功能,它们解决了功能与隐私之间的关键矛盾,这一矛盾曾限制了 AI 在注重安全的环境中的应用。

Model Context Protocol 的标准化架构确保了随着生态系统的发展,开发者可以一次构建,处处集成。无论您是使用自定义工具扩展现有的 AI 助手,还是构建全新的应用,本地 MCP 服务器都为安全、高性能的 AI 集成提供了基础。

对于优先考虑数据隐私、离线功能和实时性能的开发者和组织而言,本地 MCP 服务器不仅仅是一个选项——它们是下一代 AI 驱动工具的必要基础设施。