リモートMCPサーバー:アーキテクチャと統合

急速に進化する人工知能の分野において、大規模言語モデル(LLM)を外部のツールやデータソースに接続する能力は最も重要です。Model Context Protocol (MCP) は、これらの接続を促進するための基礎となるオープンスタンダードとして登場しました。ローカルのMCPサーバーは開発やテストには優れていますが、リモートMCPサーバーは、スケーラブルで本番環境レベルのAIアプリケーションを解き放つ鍵となります。この記事では、リモートMCPサーバーのアーキテクチャ、利点、統合について探り、この強力な技術を活用しようとしている開発者やプロダクトリーダー向けのガイドを提供します。

MCPアーキテクチャの理解

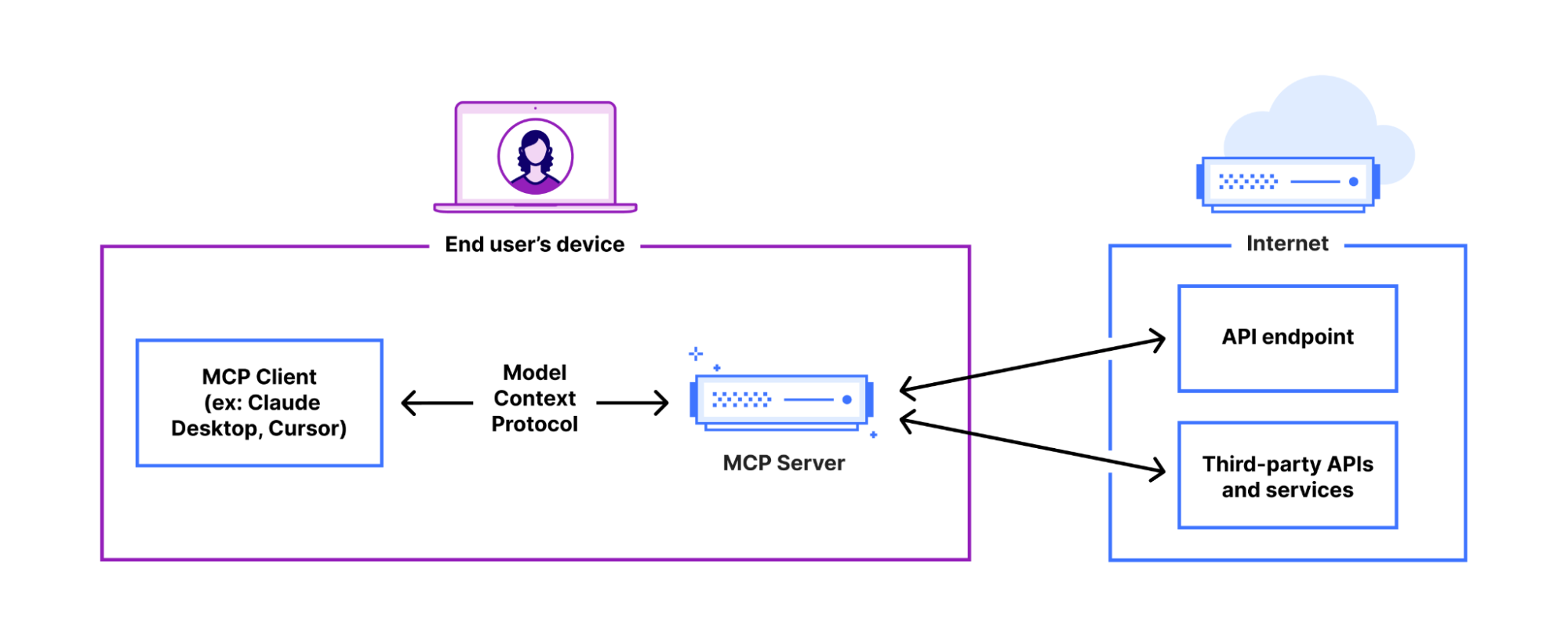

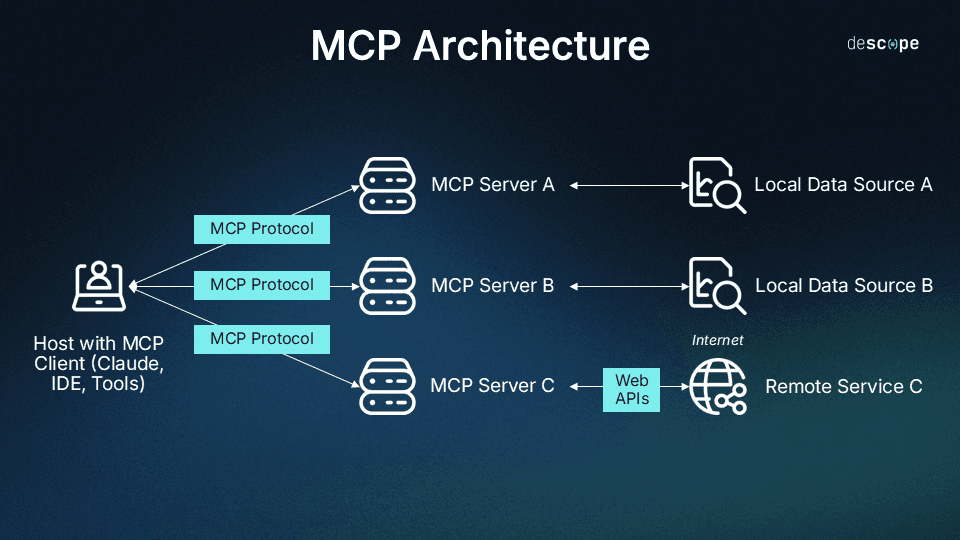

リモートサーバーに飛び込む前に、Model Context Protocolのコアコンポーネントを理解することが不可欠です。公式MCP仕様では、セキュリティ、モジュール性、スケーラビリティのために設計されたクライアント-ホスト-サーバーアーキテクチャが概説されています。

- サーバー: MCPサーバーは、ツール、リソース、プロンプトなどの一連の機能をAIモデルに公開する特殊なアプリケーションです。その主な役割は、AIと特定のデータソースやAPI(例:プロジェクト管理ツール、データベース、天気予報サービス)との間の橋渡しをすることです。サーバーはローカルプロセスまたはリモートサービスにすることができます。

- ホスト: ホストは、1つ以上のクライアントインスタンスを管理する調整プロセスです。さまざまなクライアントからコンテキストを集約し、ユーザー認証を処理し、セキュリティポリシーを強制する責任があります。多くの実用的なアプリケーションでは、ホストはデスクトップアプリやウェブアプリのようなユーザー向けのアプリケーションです。

- クライアント: ホストによって作成されたクライアントは、単一のMCPサーバーとのステートフルで分離されたセッションを維持します。低レベルのプロトコル交渉とメッセージルーティングを処理し、各サーバー接続が明確で安全であることを保証します。

MCPの重要な設計原則は、サーバーが会話の全履歴を見るべきではないということです。サーバーは特定の機能を実行するために必要なコンテキストのみを受け取ります。これは、分離を保証し、ユーザーのプライバシーを保護する重要なセキュリティ機能です。

リモートMCPサーバーとは?

リモートMCPサーバーはローカルのものと機能的に同じですが、決定的な違いがあります。それは、ユーザーのローカルマシンで実行されるのではなく、インターネット上でホストされ、公開URLを介してアクセスできることです。この違いにより、MCPは開発者のローカル環境から、スケーラブルな分散システムの領域へと移行します。

これらのサーバーは、広大なサービスエコシステムへのリモートアクセスを提供することで、AIエージェントが利用できる機能を拡張します。ローカルマシンのツールに限定される代わりに、AIエージェントはGitHub、Asana、Sentry、PayPalなどの企業がホストするサーバーに安全に接続し、複雑な現実世界のタスクを実行できます。このアーキテクチャにより、AIは例えば、プロジェクト管理システムで新しいタスクを作成したり、監視プラットフォームからエラーログを取得したり、支払いを処理したりすることを、すべて標準化されたプロトコルを通じて可能にします。

リモートサーバーを使用する主な利点

MCPにリモートサーバーアーキテクチャを採用することは、AIを活用したアプリケーションを構築する開発者や組織にとって大きな利点をもたらします。

- スケーラビリティと可用性: リモートサーバーは堅牢なクラウドインフラストラクチャにデプロイできます。これにより、多数のユーザーからの大量のリクエストを同時に処理でき、高い可用性とパフォーマンスを確保できます。これは、あらゆる本番アプリケーションにとって必須です。

- 一元管理とセキュリティ: 企業は自社サービス用に単一の公式MCPサーバーを維持できます。これにより、すべての統合が一貫性があり、最新で、安全であることが保証されます。アクセスはOAuth 2.0のような標準的な認証プロトコルを通じて制御でき、詳細な権限設定と不正なツール使用の防止が可能になります。

- 拡張されたツールエコシステム: エンドユーザーにとっての主な利点は、利用可能なツールが大幅に拡大することです。主要なテクノロジー企業から提供される高品質なリモートサーバーの厳選リストがすでに利用可能で、プロジェクト管理、コード分析、支払い処理などのツールを提供しています。これにより、AIエージェントが異なるプロバイダーのツールを組み合わせて複雑なワークフローを達成できる、豊かで相互運用可能なエコシステムが生まれます。

- 簡素化されたクライアントサイドロジック: ツールの実装をリモートサーバーにオフロードすることで、クライアントサイドのアプリケーション(「ホスト」)は軽量なままです。クライアントは、使用するすべてのツールの特定の実装詳細ではなく、MCPを介して通信する方法を知るだけで済みます。

リモートMCPサーバーの構築とデプロイ

包括的なSDKと最新のデプロイメントプラットフォームのおかげで、リモートMCPサーバーの構築を始めるのは、見た目よりも簡単です。

主な実装手順

サーバーは、MCPに準拠するために、通常はHTTPを介していくつかの主要なエンドポイントを公開する必要があります。

- /capabilities: このエンドポイントは、サーバーが提供するツールとリソースのリストを、そのスキーマ(つまり、必要な入力と期待される出力)とともに返します。これにより、AIモデルはツールが何をするのか、どのように使用するのかを理解できます。

- /run: このエンドポイントは、特定のツールを呼び出すために使用されます。リクエストにはツールの名前と必要な入力パラメータが含まれます。サーバーはツールのロジックを実行し、結果を返します。

- /health: サーバーの稼働時間と可用性を監視するための標準的なヘルスチェックエンドポイントです。

これらのサーバーを構築するには、FastAPI(Python)やExpress(Node.js)などのフレームワークが一般的に使用されます。公式のMCP SDKは、定型的なコードの多くを抽象化するヘルパークラスやデコレータを提供し、開発者がツールのコアロジックに集中できるようにします。

デプロイメントオプション

ホスティングプラットフォームの選択は、パフォーマンスとスケーラビリティにとって重要です。

- エッジコンピューティング(Cloudflare Workers): Cloudflare WorkersのようなエッジネットワークにMCPサーバーをデプロイすると、コードをエンドユーザーの近くで実行することで遅延を最小限に抑えます。これは、ほぼリアルタイムの応答を必要とするアプリケーションに最適です。

- コンテナ化(Docker/Fly.io): より複雑な環境や依存関係を必要とするアプリケーションの場合、Dockerでサーバーをコンテナ化し、Fly.ioのようなプラットフォームにデプロイすると、制御とグローバルな分散のバランスが取れます。

- サーバーレス関数: VercelやAWS LambdaのようなプラットフォームもMCPサーバーをホストでき、費用対効果が高く、自動スケーリングするソリューションを提供します。

認証と認可

些細なアプリケーションでない限り、セキュリティは主要な関心事です。リモートMCPサーバーは、機密データやアクションを保護するために堅牢な認証を実装する必要があります。標準的なアプローチはOAuth 2.0を使用することです。クライアントが接続を試みると、サーバーはOAuthフローを開始し、ユーザーをIDプロバイダー(例:Google、GitHub、またはサービス独自のログインシステム)にリダイレクトして許可を与えます。承認されると、クライアントはアクセストークンを受け取り、それを後続の/runエンドポイントへのリクエストに含めることで、サーバーが各ツール呼び出しの権限を検証できるようになります。

リモートサーバーへの接続:MCPクライアントの役割

リモートMCPサーバーの力は、ユーザーがそれらに確実に接続する方法があって初めて実現します。ここでMCPクライアントが登場します。MCPクライアントは、ユーザーがリモートサーバーによって公開されたツールを発見、接続、利用できるようにするアプリケーションです。

その代表的な例が、MCPエコシステム専用に構築された最初のAIエージェントである**Jenova**です。Jenovaは、誰もがリモートMCPサーバーを簡単、確実、スケーラブルに使用できるように設計された、洗練されたエージェント型クライアントとして機能します。いくつかの主要な分野で優れています。

- シームレスなサーバー統合: ユーザーはURLだけでJenovaを任意のリモートMCPサーバーに接続できます。接続すると、サーバーのツールはエージェント内で即座に使用可能になります。

- マルチステップのエージェント型ワークフロー: Jenovaはユーザーの目標を理解し、複雑なマルチステップのタスクをインテリジェントに計画・実行できます。例えば、金融サーバーのツールを使って製品データを見つけ、別のツールでレポートを生成し、さらに別のツールでSlackのチームメイトに要約をメッセージすることができます。

- スケーラブルで信頼性の高いツール: マルチエージェントアーキテクチャ上に構築されたJenovaは、パフォーマンスを低下させることなく膨大な数のツールをサポートするように設計されています。これにより、統合できるツールの数に厳しい制限がある他のクライアントに対して大きな利点があります。

- マルチモデルインテリジェンス: Jenovaはモデルに依存せず、GPT、Claude、Geminiなどの主要なLLMと連携します。これにより、ユーザーは単一のエコシステムに縛られることなく、常にタスクに最適な結果を得ることができます。

- すべての人にアクセス可能: 開発者にとって十分に強力でありながら、Jenovaは技術者でないユーザーがカレンダーの招待状の送信からドキュメントの編集まで、日常的なタスクにMCPエコシステムを活用できるように設計されています。また、モバイル(iOSおよびAndroid)でのMCPを完全にサポートし、あらゆるデバイスにエージェントの力をもたらします。

未来はリモートで相互運用可能

リモートMCPサーバーは、AIの風景をサイロ化されたモデルの集合体から、真に相互運用可能なインテリジェントサービスのネットワークへと変革しています。AIとツールの間の通信プロトコルを標準化することで、MCPは開発者が強力で専門的なサーバーを構築し、ユーザーがJenovaのような高度なクライアントを通じてそれらを斬新な方法で組み合わせることができる未来を可能にします。Anthropicなどがリストアップしているような、公開およびプライベートのリモートサーバーのエコシステムが成長するにつれて、洗練されたコンテキスト認識型のAIアプリケーションを構築する可能性は拡大し続け、人工知能における次のイノベーションの波を推進するでしょう。