ローカルMCPサーバーAI:プライバシーとパフォーマンスでAIツールを拡張

2025-07-17

ローカルMCPサーバーは、お使いのマシン上で直接実行されることで、AIアプリケーションがデータやツールと対話する方法を変革します。機密情報をインターネット経由で送信するクラウドベースのソリューションとは異なり、ローカルサーバーはすべてをデバイス上で処理するため、完全なプライバシーを確保しつつ、ほぼ瞬時のパフォーマンスを提供します。

主な利点:

- ✅ 外部サーバーへのデータ送信ゼロ

- ✅ 直接通信によるミリ秒未満の応答時間

- ✅ インターネットに依存しない完全なオフライン機能

- ✅ あらゆるローカルワークフローに対応する無制限のカスタマイズ

このアーキテクチャがなぜ重要なのかを理解するために、今日AI搭載アプリケーションを構築している開発者や組織が直面している課題を見ていきましょう。

クイックアンサー:ローカルMCPサーバーとは?

ローカルMCPサーバーは、コンピュータ上で実行されるプログラムで、ローカルのファイル、データベース、アプリケーションへの安全で直接的なアクセスを提供することでAIの能力を拡張します。 これらはModel Context Protocol (MCP)標準を使用して、インターネット経由で情報を送信することなく、AIクライアントにツールやデータソースを公開します。

主な機能:

- 機密データを完全にデバイス上で処理し、最大限のプライバシーを確保

- AIがローカルのファイル、コードベース、アプリケーションと対話できるようにする

- 直接的なプロセス間通信によりリアルタイムのパフォーマンスを実現

- クラウドに依存せず完全にオフラインで機能

問題点:AIツールには安全なローカルアクセスが必要

AIアシスタントがより高度になるにつれて、ユーザーの個人的な環境とのより深い統合が必要になります。しかし、これは根本的な課題を生み出します。

**開発者の73%**が、AIツールが独自のコードベースや機密データにアクセスすることに懸念を表明しています。

AI導入における重大な障壁:

- プライバシーリスク – 機密ファイルやデータをクラウドサービスに送信すること

- ネットワーク遅延 – リモートサーバーとの往復通信による遅延

- 接続要件 – 安定したインターネット接続への依存

- 限定的なカスタマイズ – 特殊なローカルツールとの統合ができないこと

- データガバナンス – 企業のセキュリティポリシーとのコンプライアンス上の課題

プライバシーとセキュリティに関する懸念

AIツールがクラウド接続を必要とする場合、すべてのファイルアクセス、データベースクエリ、コードスニペットは外部サーバーに送信されなければなりません。独自のコードや規制対象データを扱う企業にとって、これは許容できないリスクを生み出します。

445万ドル – IBM Securityによると、2023年のデータ侵害の平均コスト。

GDPR、HIPAA、その他のデータ保護規制の対象となる組織は、クラウドベースのAIサービスを使用する際に、さらなるコンプライアンスの負担に直面します。暗号化されていても、データを外部に送信する行為自体が、しばしば内部のセキュリティポリシーに違反します。

パフォーマンスのボトルネック

クラウドベースのAIツールは、すべての対話で遅延を引き起こします。ローカルではマイクロ秒で完了する単純なファイル読み取り操作が、リモートサーバーを経由すると100〜500ミリ秒かかることがあります。

200-300ms – Cloudflareによると、クラウドAPI呼び出しの典型的な往復遅延時間。

コード補完、リアルタイムデバッグ、高速なファイル検索などのインタラクティブなワークフローでは、この遅延が急速に積み重なり、ユーザーエクスペリエンスと生産性を低下させます。

オフラインの制限

クラウドに依存するAIツールは、インターネット接続がないと完全に利用できなくなります。飛行機の中、遠隔地、またはネットワーク障害時に作業する開発者は、他のリソースも限られているまさにその時に、重要なAI支援へのアクセスを失います。

解決策:安全なAI拡張のためのローカルMCPサーバー

ローカルMCPサーバーは、お使いのマシン上で直接実行されることでこれらの課題を解決し、AIクライアントとローカル環境の間に安全な橋を架けます。Model Context Protocolは、この統合のための標準化されたアーキテクチャを提供します。

| 従来のクラウドAI | ローカルMCPサーバー |

|---|---|

| データを外部サーバーに送信 | すべての処理をデバイス上で実行 |

| 200-500msのネットワーク遅延 | ミリ秒未満の応答時間 |

| インターネット接続が必要 | 完全なオフライン機能 |

| 事前構築済みの統合に限定 | 無制限のカスタムツール作成 |

| サードパーティによるデータアクセス | ユーザーが制御する権限 |

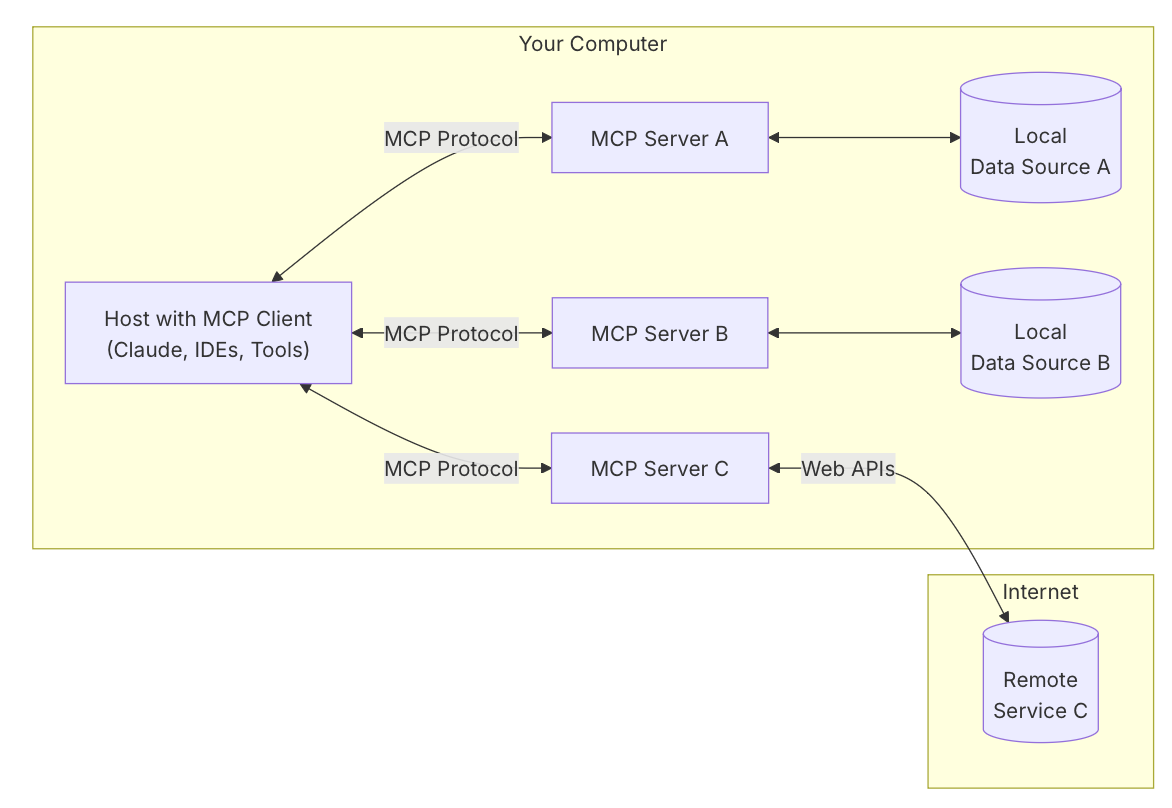

MCPアーキテクチャの理解

Model Context Protocolは、3つのコンポーネントモデルで動作します。

ホストアプリケーション ユーザーが対話する主要なAI搭載アプリケーション—AIチャットアシスタント、コードエディタ、デスクトップエージェントなど。ここでユーザーはリクエストを行い、レスポンスを受け取ります。

MCPクライアント ホストに組み込まれたクライアントがプロトコル通信を処理します。接続されたサーバーから利用可能なツールを発見し、ユーザーのリクエストをツール呼び出しに変換し、実行フローを管理します。

MCPサーバー 標準化されたインターフェースを通じて特定の機能を提供する別のプログラム。ローカル設定では、サーバーは同じマシン上で実行され、標準入出力(stdio)を介して通信します。これはネットワークのオーバーヘッドを排除する直接的なプロセス間通信方法です。

プライバシー第一のアーキテクチャ

ローカルサーバーは、機密データが決してマシンから離れないことを保証します。AIがプライベートなコードベース、個人ファイル、またはローカルデータベースにアクセスする必要がある場合、サーバーはリクエストを完全にデバイス上で処理します。外部サービスに情報が送信されることはありません。

すべての操作には、ホストアプリケーションを介したユーザーの明示的な承認が必要です。ユーザーはAIがアクセス、変更、実行できるものを完全に制御し、クラウドベースの代替手段とは根本的に異なる信頼モデルを構築します。

直接通信によるパフォーマンス

プロセス間通信にstdioを使用することで、ローカルサーバーはミリ秒ではなくマイクロ秒単位で測定される応答時間を実現します。この直接接続により、以下が排除されます。

- ネットワークのシリアライズ/デシリアライズのオーバーヘッド

- TLSハンドシェイクの遅延

- インターネットルーティングの遅延

- APIのレート制限

- サーバーキューの待機時間

コード分析、ファイルナビゲーション、リアルタイムのデータ検索など、頻繁で小さな対話を伴うワークフローでは、このパフォーマンスの違いがユーザーエクスペリエンスを変革します。

オフライン第一の機能

ローカルサーバーはインターネット接続とは独立して機能します。AIアシスタントは、飛行中、接続が悪い地域、またはネットワーク障害時にも価値を提供し続けることができます。この信頼性により、接続が保証されないミッションクリティカルなワークフローでもAI搭載ツールが利用可能になります。

ローカルMCPサーバーの仕組み:ステップバイステップ

ローカルMCPサーバーの実装は、既存のサーバーを使用する場合でも、カスタムソリューションを構築する場合でも、簡単なプロセスに従います。

ステップ1:MCPサーバーのインストール

ユースケースに合わせてサーバープログラムをダウンロードまたはビルドします。Awesome MCP Serversリポジトリには、ファイルシステムアクセス、Git統合、データベース接続などの一般的なタスクに対応する数十の事前構築済みオプションが用意されています。カスタムのニーズには、Python、Node.js、またはC#で利用可能な公式SDKを使用します。

ステップ2:ホストアプリケーションの設定

AIクライアントの設定ファイル(通常はJSON形式)にサーバーを追加します。サーバーの実行可能ファイルのパスと必要なパラメータを指定します。例えば、ファイルシステムサーバーの設定は次のようになります。

json{

"mcpServers": {

"filesystem": {

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-filesystem", "/Users/username/Documents"]

}

}

}

ステップ3:起動と接続

ホストアプリケーションを起動すると、設定されたサーバーが子プロセスとして自動的に起動します。クライアントはstdio通信チャネルを確立し、ハンドシェイクを実行して利用可能なツールと機能を検出します。

ステップ4:権限の付与

AIがサーバーツールを使用しようとすると、ホストアプリケーションがユーザーの承認を求めます。特定のファイルの読み取り、コマンドの実行、データベースのクエリなど、AIが実行したいアクションを正確に確認してから権限を付与できます。

ステップ5:AI搭載ワークフローの実行

サーバーが接続され、権限が付与されると、自然言語を使用して複雑なタスクを達成できます。AIに「プロジェクト内のすべてのTODOコメントを見つけて」、「新しいReactコンポーネントを作成して」、「ローカルデータベースで最近のトランザクションをクエリして」と依頼すると、AIは接続されたサーバーを介して必要なツール呼び出しを調整します。

実世界のアプリケーションとユースケース

ローカルMCPサーバーは、開発、研究、個人生産性の分野で高度なAIワークフローを可能にします。

💻 ソフトウェア開発とコード管理

シナリオ: 開発者が、数百のファイルにわたって一貫性を保ちながら、大規模なコードベースをリファクタリングする必要がある。

従来のアプローチ: 手動でパターンを検索し、各ファイルを個別に更新し、テストを実行し、破壊的な変更を修正する。これには何時間もの集中作業が必要です。

ローカルMCPサーバーを使用: AIはファイルシステムサーバーを使用してコードベース全体をスキャンし、変更が必要なすべてのインスタンスを特定し、修正を提案し、複数のファイルにわたって同時に更新を実行します。Gitサーバーは、説明的なメッセージとともに変更をコミットします。

主な利点:

- 言語サーバー統合によるセマンティックなコード理解

- プロジェクト全体にわたる自動リファクタリング

- Git統合による即時ロールバックで安全な実験

- 独自のコードが漏洩するリスクゼロ

WorkOSによるMCPアーキテクチャの分析によると、コード支援にローカルサーバーを使用する開発者は、複雑なリファクタリングタスクの完了時間が40〜60%短縮されると報告しています。

📊 ローカルデータベースの分析と管理

シナリオ: データアナリストがローカルのPostgreSQLデータベースを調査し、スキーマの関係を理解し、レポートを生成する必要がある。

従来のアプローチ: 手動でSQLクエリを書き、結果をスプレッドシートにエクスポートし、視覚化を別々に行う。これは複数のツールを必要とする断片的なワークフローです。

ローカルMCPサーバーを使用: AIはMCPサーバーを介してローカルデータベースに接続し、スキーマを調査し、自然言語のリクエストに基づいて最適化されたクエリを生成し、結果を会話内で直接フォーマットします。

主な利点:

- SQLの専門知識なしでの自然言語によるデータベースクエリ

- 自動的なスキーマ調査と関係マッピング

- 機密データは完全にデバイス上に留まる

- AI支援により複雑な複数テーブルの結合が簡素化

📱 モバイル開発とテスト

シナリオ: モバイル開発者が、複数のデバイス構成と画面サイズでiOSアプリをテストする必要がある。

従来のアプローチ: 手動でシミュレータを起動し、アプリのフローをナビゲートし、スクリーンショットをキャプチャし、問題を文書化する。これは反復的で時間のかかる作業です。

ローカルMCPサーバーを使用: iOSシミュレータサーバーにより、AIはプログラムでシミュレータを制御し、テストシナリオを実行し、スクリーンショットをキャプチャし、テストレポートを自動的にコンパイルできます。

主な利点:

- デバイス構成全体にわたる自動UIテスト

- 自然言語によるテストケース作成

- 即時の視覚的回帰検出

- 複数のシミュレータでの並行テスト

🗂️ パーソナルナレッジマネジメント

シナリオ: 研究者が、さまざまなフォルダにまたがる何千もの文書、論文、メモを管理しており、特定の情報を迅速に見つける必要がある。

従来のアプローチ: ファイルシステム検索を使用し、手動で文書を開き、内容をスキャンし、調査結果をまとめる。これは大規模な文書コレクションには非効率です。

ローカルMCPサーバーを使用: AIはファイルシステムサーバーを使用してすべての文書を検索し、関連する一節を抽出し、調査結果を要約し、整理されたレポートを作成します。これらすべてを、機密性の高い研究データをローカルに保ちながら行います。

主な利点:

- 文書コレクション全体にわたるセマンティック検索

- 自動要約と情報抽出

- 文書横断的な統合と関連性の発見

- 機密研究に対する完全なプライバシー

カスタムローカルMCPサーバーの構築

カスタムローカルMCPサーバーの作成は、基本的なプログラミング知識を持つ開発者にとってアクセス可能です。公式MCPサーバークイックスタートガイドは、包括的なチュートリアルを提供しています。

開発プロセスの概要

SDKの選択 公式SDKはPython、TypeScript/Node.js、C#で利用可能です。好みの言語と統合する必要があるライブラリのエコシステムに基づいて選択してください。

ツール機能の定義 公開したい各機能のコアロジックを実装します。例えば、ファイル検索ツールはクエリ文字列を受け取り、一致するファイルパスと抜粋を返すかもしれません。

python@server.tool()

async def search_files(query: str, directory: str) -> list[dict]:

"""Search for files containing the query string."""

results = []

for root, dirs, files in os.walk(directory):

for file in files:

# Search logic here

pass

return results

サーバーの初期化 MCPライブラリを使用してサーバーインスタンスを作成し、ツールを登録し、stdioトランスポートを設定します。

ロギングの正しい処理 stdioはJSON-RPC通信に使用されるため、余分な出力はプロトコルを破損させます。すべてのロギングをstderrまたは別のログファイルにリダイレクトしてください。

pythonimport logging

logging.basicConfig(

level=logging.INFO,

handlers=[logging.FileHandler('server.log')]

)

テストとデプロイ 互換性のあるホストアプリケーションでサーバーを設定してテストします。配布する前に、ツールの検出、実行、エラー処理を確認してください。

セキュリティに関する考慮事項

ローカルサーバーを構築する際は、適切なセキュリティ対策を実装してください。

- 入力検証: パストラバーサルやコマンドインジェクションを防ぐために、すべてのパラメータをサニタイズします。

- 権限のスコープ設定: サーバーのアクセスを特定のディレクトリやリソースに制限します。

- エラー処理: システムの内部を公開することなく、明確なエラーメッセージを提供します。

- 監査ログ: セキュリティレビューのためにすべての操作を記録します。

よくある質問

ローカルMCPサーバーはクラウドベースのAI APIとどう違いますか?

ローカルMCPサーバーは完全にマシン上で実行され、データをデバイス上で処理しますが、クラウドAPIはデータを外部サーバーに送信します。ローカルサーバーは優れたプライバシー、低い遅延(ミリ秒未満 vs 200-500ms)、オフライン機能を提供します。クラウドAPIはより大きな計算能力と、リソース集約的なタスクのための簡単なスケーリングを提供します。最適なアプローチはしばしば両方を組み合わせることです:機密操作にはローカルサーバーを、重い計算にはクラウドサービスを使用します。

どのAIアシスタントでもローカルMCPサーバーを使用できますか?

ローカルMCPサーバーは、MCPクライアントプロトコルを実装する任意のホストアプリケーションで動作します。現在、これにはClaude Desktop、特定のAI強化IDE、およびMCP SDKで構築されたカスタムアプリケーションが含まれます。プロトコルの採用が進むにつれて、より多くのAIツールがネイティブサポートを追加するでしょう。公式のMCPクライアントライブラリを使用して独自のホストアプリケーションを構築することもできます。

ローカルMCPサーバーを使用するにはプログラミング知識が必要ですか?

事前構築済みのサーバーを使用するには、最小限の技術知識しか必要ありません。通常は、サーバーパスを指定するためにJSON設定ファイルを編集するだけです。カスタムサーバーの構築にはPython、TypeScript、またはC#でのプログラミングスキルが必要ですが、公式のSDKとドキュメントにより、基本的な経験を持つ開発者でもプロセスにアクセスできます。Awesome MCP Serversリポジトリは、一般的なタスク用のすぐに使えるサーバーを提供しています。

ローカルMCPサーバーを実行するためのパフォーマンス要件は何ですか?

ローカルMCPサーバーは、特定のタスクに焦点を当てた軽量プログラムであるため、オーバーヘッドは最小限です。ほとんどのサーバーは、アイドル時に50MB未満のRAMとごくわずかなCPUしか消費しません。パフォーマンス要件は特定の操作に依存します。ファイルシステムサーバーには高速なディスクI/Oが必要であり、データベースサーバーはクエリキャッシングのために十分なRAMの恩恵を受けます。過去5〜7年以内の現代的なコンピュータであれば、パフォーマンスの低下なしに複数のローカルサーバーを同時に実行できます。

ローカルMCPサーバーは企業での使用に安全ですか?

ローカルMCPサーバーは、データがユーザーのマシンから決して離れないため、企業環境に強力なセキュリティを提供します。すべての操作には、ホストアプリケーションを介したユーザーの明示的な承認が必要です。ただし、組織は追加の制御を実装する必要があります:従業員がインストールできるサーバーを制限し、サーバーのソースコードをセキュリティ脆弱性について監査し、ホストアプリケーションの設定を通じて権限ポリシーを強制します。デバイス上のアーキテクチャは、本質的にほとんどのデータ所在地およびプライバシー規制を満たしています。

ローカルMCPサーバーはクラウドベースのAIサービスと連携できますか?

はい、ローカルサーバーとクラウドベースのサーバーは、MCPアーキテクチャ内でシームレスに連携できます。単一のAIアシスタントは、機密操作(プライベートファイルへのアクセス、ローカルデータベースのクエリ)にローカルサーバーを使用し、リソース集約的なタスク(大規模なデータ処理、外部API統合)にクラウドサーバーを活用できます。このハイブリッドアプローチは、ローカルサーバーのプライバシーとパフォーマンスを、クラウドインフラストラクチャのスケーラビリティと組み合わせます。

結論:プライバシー第一のAI統合の未来

ローカルMCPサーバーは、AIアプリケーションがユーザーデータにアクセスし、処理する方法における根本的な変化を表しています。機密情報をデバイス上に保持しながら、高度なAI機能を可能にすることで、セキュリティを重視する環境でのAI導入を制限してきた機能性とプライバシーの間の重大な緊張を解決します。

Model Context Protocolの標準化されたアーキテクチャは、エコシステムが成長するにつれて、開発者が一度構築すればどこにでも統合できることを保証します。既存のAIアシスタントをカスタムツールで拡張する場合でも、まったく新しいアプリケーションを構築する場合でも、ローカルMCPサーバーは安全で高性能なAI統合の基盤を提供します。

データプライバシー、オフライン機能、リアルタイムパフォーマンスを優先する開発者や組織にとって、ローカルMCPサーバーは単なる選択肢ではなく、次世代のAI搭載ツールにとって不可欠なインフラストラクチャです。