Server MCP Locali AI: Estendere gli Strumenti AI con Privacy e Prestazioni

2025-07-17

I server MCP locali trasformano il modo in cui le applicazioni AI interagiscono con i tuoi dati e strumenti, eseguendosi direttamente sulla tua macchina. A differenza delle soluzioni basate su cloud che trasmettono informazioni sensibili su Internet, i server locali elaborano tutto sul dispositivo, garantendo una privacy completa e offrendo prestazioni quasi istantanee.

Vantaggi principali:

- ✅ Zero trasmissione di dati a server esterni

- ✅ Tempi di risposta inferiori al millisecondo tramite comunicazione diretta

- ✅ Piena funzionalità offline senza dipendenza da Internet

- ✅ Personalizzazione illimitata per qualsiasi flusso di lavoro locale

Per capire perché questa architettura è importante, esaminiamo le sfide che sviluppatori e organizzazioni affrontano oggi nella creazione di applicazioni basate sull'AI.

Risposta Rapida: Cosa Sono i Server MCP Locali?

I server MCP locali sono programmi che vengono eseguiti sul tuo computer per estendere le capacità dell'AI fornendo un accesso sicuro e diretto a file, database e applicazioni locali. Utilizzano lo standard Model Context Protocol (MCP) per esporre strumenti e fonti di dati ai client AI senza inviare informazioni su Internet.

Capacità principali:

- Elaborano dati sensibili interamente sul dispositivo per la massima privacy

- Consentono all'AI di interagire con file, codebase e applicazioni locali

- Offrono prestazioni in tempo reale tramite comunicazione diretta tra processi

- Funzionano completamente offline senza dipendenze dal cloud

Il Problema: Gli Strumenti AI Necessitano di un Accesso Locale Sicuro

Man mano che gli assistenti AI diventano più sofisticati, richiedono un'integrazione più profonda con gli ambienti personali degli utenti. Tuttavia, questo crea sfide fondamentali:

Il 73% degli sviluppatori esprime preoccupazione per gli strumenti AI che accedono alle loro codebase proprietarie e ai dati sensibili.

Barriere critiche all'adozione dell'AI:

- Rischi per la Privacy – Trasmissione di file e dati sensibili a servizi cloud

- Latenza di Rete – Ritardi dovuti alla comunicazione di andata e ritorno con server remoti

- Requisiti di Connettività – Dipendenza da connessioni Internet stabili

- Personalizzazione Limitata – Incapacità di integrarsi con strumenti locali specializzati

- Governance dei Dati – Sfide di conformità con le politiche di sicurezza aziendali

Preoccupazioni per Privacy e Sicurezza

Quando gli strumenti AI richiedono connettività cloud, ogni accesso a file, query di database o frammento di codice deve essere trasmesso a server esterni. Per le aziende che gestiscono codice proprietario o dati regolamentati, questo crea un rischio inaccettabile.

4,45 milioni di dollari – Costo medio di una violazione dei dati nel 2023, secondo IBM Security.

Le organizzazioni soggette a GDPR, HIPAA o altre normative sulla protezione dei dati affrontano ulteriori oneri di conformità quando utilizzano servizi AI basati su cloud. Anche con la crittografia, l'atto di trasmettere dati esternamente viola spesso le politiche di sicurezza interne.

Colli di Bottiglia nelle Prestazioni

Gli strumenti AI basati su cloud introducono latenza ad ogni interazione. Una semplice operazione di lettura di file che richiede microsecondi a livello locale può richiedere 100-500 millisecondi se instradata attraverso server remoti.

200-300ms – Latenza tipica di andata e ritorno per le chiamate API cloud, secondo Cloudflare.

Per flussi di lavoro interattivi — completamento del codice, debug in tempo reale o ricerche rapide di file — questo ritardo si accumula rapidamente, degradando l'esperienza utente e la produttività.

Limitazioni Offline

Gli strumenti AI dipendenti dal cloud diventano completamente inutilizzabili senza connettività Internet. Gli sviluppatori che lavorano in aereo, in luoghi remoti o durante interruzioni di rete perdono l'accesso all'assistenza AI critica proprio quando anche le risorse alternative sono limitate.

La Soluzione: Server MCP Locali per un'Estensione AI Sicura

I server MCP locali risolvono queste sfide eseguendosi direttamente sulla tua macchina, creando un ponte sicuro tra i client AI e il tuo ambiente locale. Il Model Context Protocol fornisce un'architettura standardizzata per questa integrazione.

| AI Cloud Tradizionale | Server MCP Locali |

|---|---|

| Dati trasmessi a server esterni | Tutta l'elaborazione sul dispositivo |

| Latenza di rete di 200-500ms | Tempi di risposta inferiori al millisecondo |

| Richiede connettività Internet | Piena funzionalità offline |

| Limitato a integrazioni predefinite | Creazione illimitata di strumenti personalizzati |

| Accesso ai dati da parte di terzi | Permessi controllati dall'utente |

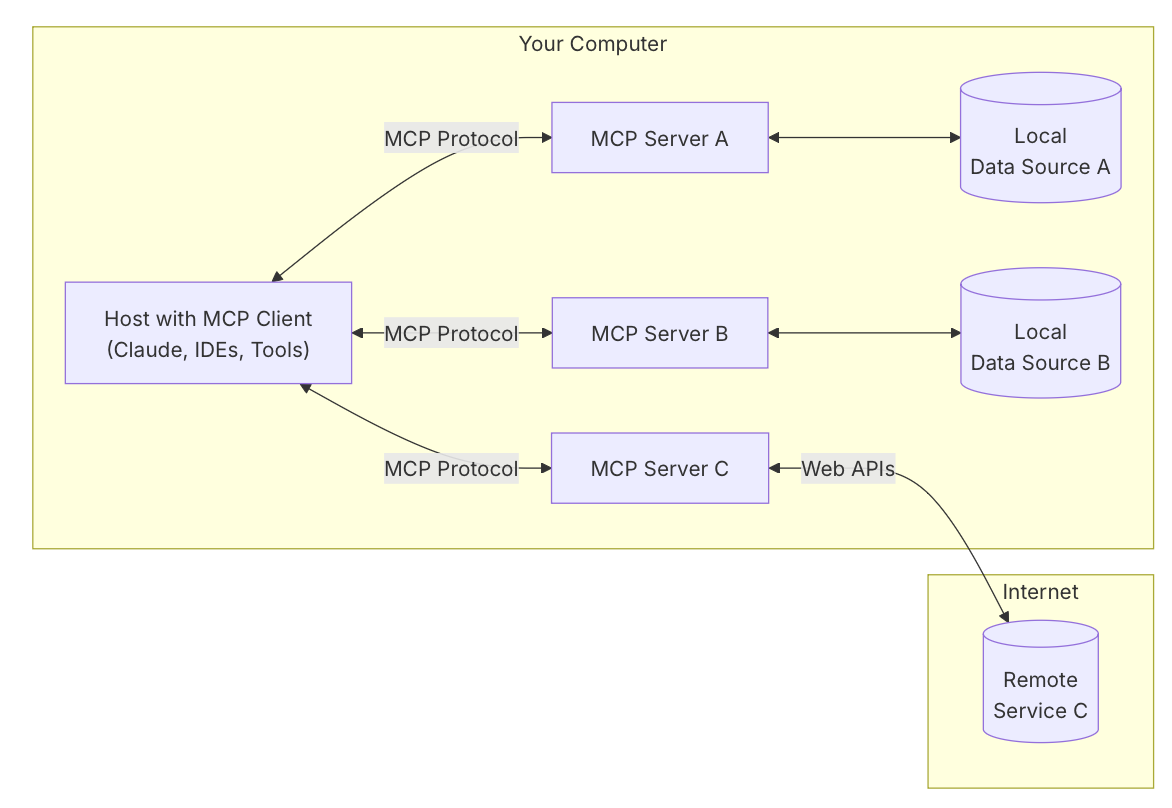

Comprendere l'Architettura MCP

Il Model Context Protocol opera su un modello a tre componenti:

Applicazione Host L'applicazione principale basata su AI con cui gli utenti interagiscono, come un assistente chat AI, un editor di codice o un agente desktop. È qui che gli utenti fanno richieste e ricevono risposte.

Client MCP Incorporato nell'host, il client gestisce la comunicazione del protocollo. Scopre gli strumenti disponibili dai server connessi, traduce le richieste degli utenti in chiamate di strumenti e gestisce il flusso di esecuzione.

Server MCP Un programma separato che espone capacità specifiche attraverso interfacce standardizzate. Nelle configurazioni locali, i server vengono eseguiti sulla stessa macchina e comunicano tramite Standard Input/Output (stdio), un metodo di comunicazione diretta tra processi che elimina l'overhead di rete.

Architettura Privacy-First

I server locali garantiscono che i dati sensibili non lascino mai la tua macchina. Quando un'AI deve accedere a una codebase privata, file personali o database locali, il server elabora le richieste interamente sul dispositivo. Nessuna informazione viene trasmessa a servizi esterni.

Tutte le operazioni richiedono l'approvazione esplicita dell'utente tramite l'applicazione host. Gli utenti mantengono il controllo completo su ciò che l'AI può accedere, modificare o eseguire, creando un modello di fiducia fondamentalmente diverso dalle alternative basate su cloud.

Prestazioni Tramite Comunicazione Diretta

Utilizzando stdio per la comunicazione tra processi, i server locali raggiungono tempi di risposta misurati in microsecondi anziché millisecondi. Questa connessione diretta elimina:

- Overhead di serializzazione/deserializzazione di rete

- Ritardi dell'handshake TLS

- Latenza di routing Internet

- Rate limiting delle API

- Tempi di attesa in coda del server

Per flussi di lavoro che coinvolgono interazioni frequenti e piccole — analisi del codice, navigazione tra file o ricerche di dati in tempo reale — questa differenza di prestazioni trasforma l'esperienza utente.

Capacità Offline-First

I server locali funzionano indipendentemente dalla connettività Internet. Gli assistenti AI possono continuare a fornire valore durante i voli, in aree con scarsa connettività o durante interruzioni di rete. Questa affidabilità rende gli strumenti basati sull'AI validi per flussi di lavoro mission-critical in cui la connettività non può essere garantita.

Come Funzionano i Server MCP Locali: Passo dopo Passo

L'implementazione di un server MCP locale segue un processo semplice, sia che tu stia utilizzando un server esistente o costruendo una soluzione personalizzata.

Passo 1: Installa il Server MCP

Scarica o costruisci il programma server per il tuo caso d'uso. Il repository Awesome MCP Servers fornisce dozzine di opzioni predefinite per compiti comuni come l'accesso al file system, l'integrazione con Git o la connettività a database. Per esigenze personalizzate, utilizza gli SDK ufficiali disponibili in Python, Node.js o C#.

Passo 2: Configura l'Applicazione Host

Aggiungi il server al file di configurazione del tuo client AI (tipicamente in formato JSON). Specifica il percorso dell'eseguibile del server e qualsiasi parametro richiesto. Ad esempio, una configurazione di un server filesystem potrebbe assomigliare a:

json{

"mcpServers": {

"filesystem": {

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-filesystem", "/Users/username/Documents"]

}

}

}

Passo 3: Avvia e Connetti

Quando avvii l'applicazione host, essa lancia automaticamente i server configurati come processi figli. Il client stabilisce canali di comunicazione stdio ed esegue un handshake per scoprire gli strumenti e le capacità disponibili.

Passo 4: Concedi i Permessi

Quando l'AI tenta di utilizzare gli strumenti del server, l'applicazione host richiede l'approvazione dell'utente. Puoi rivedere esattamente quale azione l'AI vuole eseguire — leggere un file specifico, eseguire un comando o interrogare un database — prima di concedere il permesso.

Passo 5: Esegui Flussi di Lavoro Basati sull'AI

Con i server connessi e i permessi concessi, puoi usare il linguaggio naturale per compiere compiti complessi. Chiedi all'AI di "trovare tutti i commenti TODO nel mio progetto", "creare un nuovo componente React" o "interrogare il database locale per le transazioni recenti" — e l'AI orchestra le chiamate agli strumenti necessari attraverso i server connessi.

Applicazioni e Casi d'Uso nel Mondo Reale

I server MCP locali abilitano flussi di lavoro AI sofisticati nei domini dello sviluppo, della ricerca e della produttività personale.

💻 Sviluppo Software e Gestione del Codice

Scenario: Uno sviluppatore deve refattorizzare una grande codebase mantenendo la coerenza tra centinaia di file.

Approccio Tradizionale: Cercare manualmente i pattern, aggiornare ogni file individualmente, eseguire i test e correggere le modifiche che causano errori — richiedendo ore di lavoro concentrato.

Con i Server MCP Locali: L'AI utilizza un server filesystem per scansionare l'intera codebase, identifica tutte le istanze che richiedono modifiche, propone le modifiche ed esegue gli aggiornamenti su più file contemporaneamente. Un server Git committa le modifiche con messaggi descrittivi.

Vantaggi principali:

- Comprensione semantica del codice tramite l'integrazione del language server

- Refactoring automatizzato su interi progetti

- Sperimentazione sicura con rollback istantaneo tramite l'integrazione con Git

- Zero rischio di esposizione di codice proprietario

Secondo l'analisi di WorkOS sull'architettura MCP, gli sviluppatori che utilizzano server locali per l'assistenza al codice riportano tempi di completamento più rapidi del 40-60% per compiti di refactoring complessi.

📊 Analisi e Gestione di Database Locali

Scenario: Un analista di dati deve esplorare un database PostgreSQL locale, comprendere le relazioni dello schema e generare report.

Approccio Tradizionale: Scrivere query SQL manualmente, esportare i risultati in fogli di calcolo, creare visualizzazioni separatamente — un flusso di lavoro frammentato che richiede più strumenti.

Con i Server MCP Locali: L'AI si connette al database locale tramite un server MCP, esplora lo schema, genera query ottimizzate basate su richieste in linguaggio naturale e formatta i risultati direttamente nella conversazione.

Vantaggi principali:

- Query di database in linguaggio naturale senza competenze SQL

- Esplorazione automatica dello schema e mappatura delle relazioni

- I dati sensibili rimangono interamente sul dispositivo

- Join complessi su più tabelle semplificati tramite l'assistenza AI

📱 Sviluppo e Test Mobile

Scenario: Uno sviluppatore mobile deve testare un'app iOS su più configurazioni di dispositivi e dimensioni dello schermo.

Approccio Tradizionale: Avviare manualmente i simulatori, navigare attraverso i flussi dell'app, catturare screenshot e documentare i problemi — ripetitivo e dispendioso in termini di tempo.

Con i Server MCP Locali: Un server simulatore iOS consente all'AI di controllare programmaticamente i simulatori, eseguire scenari di test, catturare screenshot e compilare report di test automaticamente.

Vantaggi principali:

- Test UI automatizzati su diverse configurazioni di dispositivi

- Creazione di casi di test in linguaggio naturale

- Rilevamento istantaneo di regressioni visive

- Test paralleli su più simulatori

🗂️ Gestione della Conoscenza Personale

Scenario: Un ricercatore gestisce migliaia di documenti, articoli e note in varie cartelle e ha bisogno di trovare rapidamente informazioni specifiche.

Approccio Tradizionale: Usare la ricerca del file system, aprire manualmente i documenti, scansionare i contenuti e compilare i risultati — inefficiente per grandi collezioni di documenti.

Con i Server MCP Locali: L'AI utilizza un server filesystem per cercare in tutti i documenti, estrarre passaggi rilevanti, riassumere i risultati e creare report organizzati — il tutto mantenendo i dati di ricerca sensibili a livello locale.

Vantaggi principali:

- Ricerca semantica su intere collezioni di documenti

- Riassunto automatico ed estrazione di informazioni

- Sintesi e scoperta di connessioni tra documenti

- Privacy completa per la ricerca confidenziale

Costruire Server MCP Locali Personalizzati

Creare un server MCP locale personalizzato è accessibile agli sviluppatori con conoscenze di programmazione di base. La guida rapida ufficiale per server MCP fornisce tutorial completi.

Panoramica del Processo di Sviluppo

Scegli il tuo SDK Gli SDK ufficiali sono disponibili per Python, TypeScript/Node.js e C#. Scegli in base al tuo linguaggio preferito e all'ecosistema di librerie che devi integrare.

Definisci le Funzioni dello Strumento Implementa la logica principale per ogni capacità che vuoi esporre. Ad esempio, uno strumento di ricerca file potrebbe accettare una stringa di query e restituire i percorsi dei file corrispondenti con estratti.

python@server.tool()

async def search_files(query: str, directory: str) -> list[dict]:

"""Cerca file contenenti la stringa di query."""

results = []

for root, dirs, files in os.walk(directory):

for file in files:

# Logica di ricerca qui

pass

return results

Inizializza il Server Usa la libreria MCP per creare un'istanza del server, registrare i tuoi strumenti e configurare il trasporto stdio.

Gestisci Correttamente il Logging Poiché stdio è usato per la comunicazione JSON-RPC, qualsiasi output estraneo corrompe il protocollo. Indirizza tutto il logging a stderr o a file di log separati:

pythonimport logging

logging.basicConfig(

level=logging.INFO,

handlers=[logging.FileHandler('server.log')]

)

Testa e Distribuisci Testa il tuo server configurandolo in un'applicazione host compatibile. Verifica la scoperta degli strumenti, l'esecuzione e la gestione degli errori prima della distribuzione.

Considerazioni sulla Sicurezza

Quando costruisci server locali, implementa misure di sicurezza adeguate:

- Validazione dell'Input: Sanifica tutti i parametri per prevenire path traversal o command injection

- Scoping dei Permessi: Limita l'accesso del server a directory o risorse specifiche

- Gestione degli Errori: Fornisci messaggi di errore chiari senza esporre dettagli interni del sistema

- Logging di Audit: Registra tutte le operazioni per la revisione della sicurezza

Domande Frequenti

In cosa differiscono i server MCP locali dalle API AI basate su cloud?

I server MCP locali vengono eseguiti interamente sulla tua macchina ed elaborano i dati sul dispositivo, mentre le API cloud trasmettono i dati a server esterni. I server locali offrono una privacy superiore, una latenza inferiore (sotto il millisecondo contro 200-500ms) e funzionalità offline. Le API cloud offrono una maggiore potenza di calcolo e una scalabilità più semplice per compiti ad alta intensità di risorse. L'approccio ottimale spesso combina entrambi: server locali per operazioni sensibili e servizi cloud per calcoli pesanti.

Posso usare i server MCP locali con qualsiasi assistente AI?

I server MCP locali funzionano con qualsiasi applicazione host che implementa il protocollo client MCP. Attualmente, questo include Claude Desktop, alcuni IDE potenziati con AI e applicazioni personalizzate costruite con gli SDK MCP. Man mano che il protocollo guadagna adozione, sempre più strumenti AI aggiungeranno il supporto nativo. Puoi anche costruire la tua applicazione host usando le librerie client MCP ufficiali.

L'uso dei server MCP locali richiede conoscenze di programmazione?

L'uso di server predefiniti richiede conoscenze tecniche minime — tipicamente solo la modifica di un file di configurazione JSON per specificare il percorso del server. La costruzione di server personalizzati richiede competenze di programmazione in Python, TypeScript o C#, ma gli SDK e la documentazione ufficiali rendono il processo accessibile agli sviluppatori con esperienza di base. Il repository Awesome MCP Servers fornisce server pronti all'uso per compiti comuni.

Quali sono i requisiti di prestazione per l'esecuzione di server MCP locali?

I server MCP locali hanno un overhead minimo poiché sono programmi leggeri focalizzati su compiti specifici. La maggior parte dei server consuma meno di 50MB di RAM e una CPU trascurabile quando inattivi. I requisiti di prestazione dipendono dalle operazioni specifiche — un server filesystem necessita di un I/O su disco veloce, mentre un server di database beneficia di una RAM adeguata per la cache delle query. Qualsiasi computer moderno degli ultimi 5-7 anni può eseguire più server locali contemporaneamente senza degrado delle prestazioni.

I server MCP locali sono sicuri per l'uso aziendale?

I server MCP locali forniscono una forte sicurezza per gli ambienti aziendali perché i dati non lasciano mai la macchina dell'utente. Tutte le operazioni richiedono l'approvazione esplicita dell'utente tramite l'applicazione host. Tuttavia, le organizzazioni dovrebbero implementare controlli aggiuntivi: limitare quali server i dipendenti possono installare, controllare il codice sorgente del server per vulnerabilità di sicurezza e applicare politiche di autorizzazione tramite la configurazione dell'applicazione host. L'architettura on-device soddisfa intrinsecamente la maggior parte delle normative sulla residenza dei dati e sulla privacy.

I server MCP locali possono funzionare insieme ai servizi AI basati su cloud?

Sì, i server locali e basati su cloud possono funzionare insieme senza problemi all'interno dell'architettura MCP. Un singolo assistente AI può utilizzare server locali per operazioni sensibili (accesso a file privati, interrogazione di database locali) sfruttando al contempo i server cloud per compiti ad alta intensità di risorse (elaborazione di dati su larga scala, integrazioni API esterne). Questo approccio ibrido combina la privacy e le prestazioni dei server locali con la scalabilità dell'infrastruttura cloud.

Conclusione: Il Futuro dell'Integrazione AI Privacy-First

I server MCP locali rappresentano un cambiamento fondamentale nel modo in cui le applicazioni AI accedono ed elaborano i dati degli utenti. Mantenendo le informazioni sensibili sul dispositivo e abilitando al contempo capacità AI sofisticate, risolvono la tensione critica tra funzionalità e privacy che ha limitato l'adozione dell'AI in ambienti attenti alla sicurezza.

L'architettura standardizzata del Model Context Protocol garantisce che, man mano che l'ecosistema cresce, gli sviluppatori possano costruire una volta e integrare ovunque. Che tu stia estendendo un assistente AI esistente con strumenti personalizzati o costruendo applicazioni completamente nuove, i server MCP locali forniscono le fondamenta per un'integrazione AI sicura e ad alte prestazioni.

Per gli sviluppatori e le organizzazioni che danno priorità alla privacy dei dati, alla funzionalità offline e alle prestazioni in tempo reale, i server MCP locali non sono solo un'opzione — sono un'infrastruttura essenziale per la prossima generazione di strumenti basati sull'AI.