Serveurs MCP locaux pour l'IA : Étendez les outils d'IA avec confidentialité et performance

2025-07-17

Les serveurs MCP locaux transforment la manière dont les applications d'IA interagissent avec vos données et outils en s'exécutant directement sur votre machine. Contrairement aux solutions basées sur le cloud qui transmettent des informations sensibles sur Internet, les serveurs locaux traitent tout sur l'appareil, garantissant une confidentialité totale tout en offrant des performances quasi instantanées.

Avantages clés :

- ✅ Zéro transmission de données vers des serveurs externes

- ✅ Temps de réponse inférieurs à la milliseconde via une communication directe

- ✅ Fonctionnalité hors ligne complète sans dépendance à Internet

- ✅ Personnalisation illimitée pour tout flux de travail local

Pour comprendre pourquoi cette architecture est importante, examinons les défis auxquels sont confrontés les développeurs et les organisations qui créent aujourd'hui des applications basées sur l'IA.

Réponse rapide : Que sont les serveurs MCP locaux ?

Les serveurs MCP locaux sont des programmes qui s'exécutent sur votre ordinateur pour étendre les capacités de l'IA en fournissant un accès sécurisé et direct aux fichiers, bases de données et applications locales. Ils utilisent la norme du Model Context Protocol (MCP) pour exposer des outils et des sources de données aux clients IA sans envoyer d'informations sur Internet.

Capacités clés :

- Traiter les données sensibles entièrement sur l'appareil pour une confidentialité maximale

- Permettre à l'IA d'interagir avec les fichiers locaux, les bases de code et les applications

- Offrir des performances en temps réel grâce à la communication directe entre processus

- Fonctionner complètement hors ligne sans dépendance au cloud

Le problème : les outils d'IA ont besoin d'un accès local sécurisé

À mesure que les assistants d'IA deviennent plus sophistiqués, ils nécessitent une intégration plus profonde avec les environnements personnels des utilisateurs. Cependant, cela crée des défis fondamentaux :

73 % des développeurs expriment des inquiétudes quant à l'accès des outils d'IA à leurs bases de code propriétaires et à leurs données sensibles.

Obstacles critiques à l'adoption de l'IA :

- Risques de confidentialité – Transmission de fichiers et de données sensibles à des services cloud

- Latence du réseau – Délais dus à la communication aller-retour avec des serveurs distants

- Exigences de connectivité – Dépendance à des connexions Internet stables

- Personnalisation limitée – Incapacité à s'intégrer avec des outils locaux spécialisés

- Gouvernance des données – Défis de conformité avec les politiques de sécurité des entreprises

Préoccupations en matière de confidentialité et de sécurité

Lorsque les outils d'IA nécessitent une connectivité cloud, chaque accès à un fichier, chaque requête de base de données ou chaque extrait de code doit être transmis à des serveurs externes. Pour les entreprises qui gèrent du code propriétaire ou des données réglementées, cela crée un risque inacceptable.

4,45 millions de dollars – Coût moyen d'une violation de données en 2023, selon IBM Security.

Les organisations soumises au GDPR, à l'HIPAA ou à d'autres réglementations sur la protection des données font face à des charges de conformité supplémentaires lorsqu'elles utilisent des services d'IA basés sur le cloud. Même avec le chiffrement, le simple fait de transmettre des données à l'extérieur viole souvent les politiques de sécurité internes.

Goulots d'étranglement des performances

Les outils d'IA basés sur le cloud introduisent de la latence à chaque interaction. Une simple opération de lecture de fichier qui prend des microsecondes localement peut nécessiter 100 à 500 millisecondes lorsqu'elle est acheminée via des serveurs distants.

200-300ms – Latence aller-retour typique pour les appels d'API cloud, selon Cloudflare.

Pour les flux de travail interactifs — complétion de code, débogage en temps réel ou recherches rapides de fichiers — ce délai s'accumule rapidement, dégradant l'expérience utilisateur et la productivité.

Limitations hors ligne

Les outils d'IA dépendants du cloud deviennent complètement inutilisables sans connectivité Internet. Les développeurs travaillant en avion, dans des endroits éloignés ou pendant des pannes de réseau perdent l'accès à une assistance IA essentielle précisément lorsque les ressources alternatives sont également limitées.

La solution : les serveurs MCP locaux pour une extension sécurisée de l'IA

Les serveurs MCP locaux résolvent ces défis en s'exécutant directement sur votre machine, créant un pont sécurisé entre les clients IA et votre environnement local. Le Model Context Protocol fournit une architecture standardisée pour cette intégration.

| IA cloud traditionnelle | Serveurs MCP locaux |

|---|---|

| Données transmises à des serveurs externes | Tout le traitement sur l'appareil |

| Latence réseau de 200-500ms | Temps de réponse inférieurs à la milliseconde |

| Nécessite une connexion Internet | Fonctionnalité hors ligne complète |

| Limité aux intégrations pré-construites | Création d'outils personnalisés illimitée |

| Accès aux données par des tiers | Permissions contrôlées par l'utilisateur |

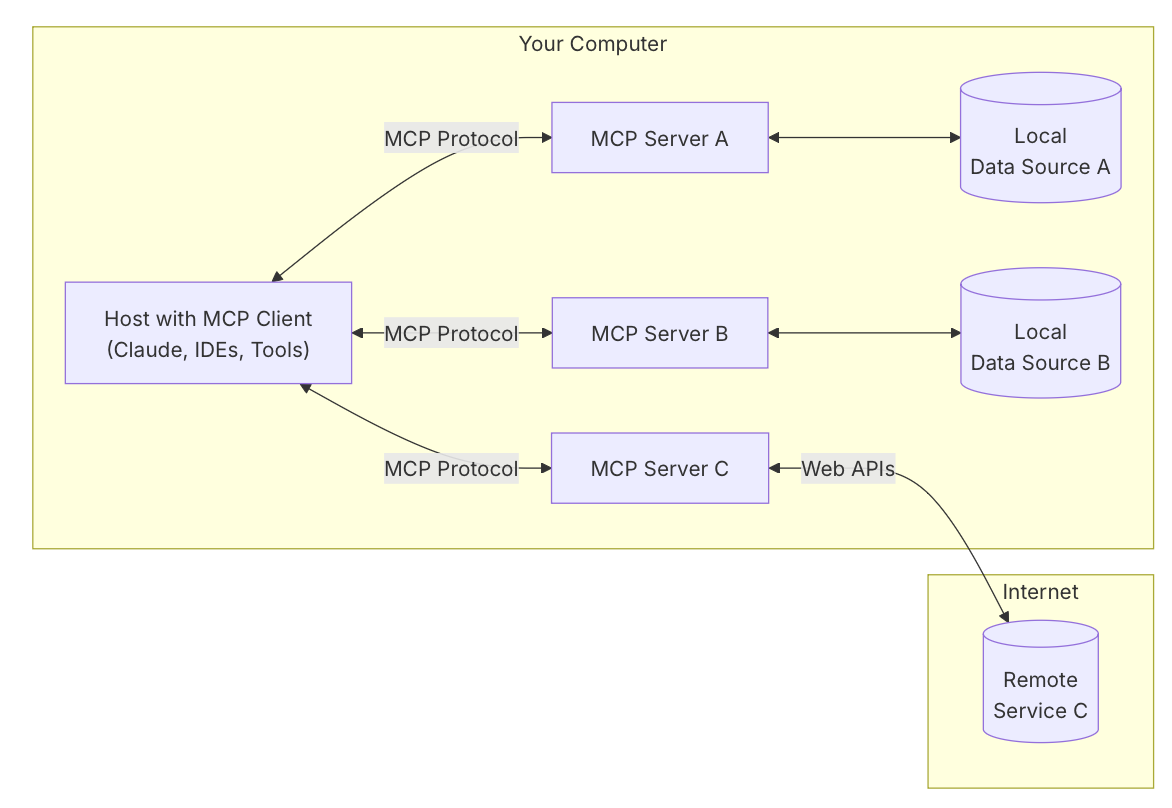

Comprendre l'architecture MCP

Le Model Context Protocol fonctionne sur un modèle à trois composants :

Application Hôte L'application principale alimentée par l'IA avec laquelle les utilisateurs interagissent, comme un assistant de chat IA, un éditeur de code ou un agent de bureau. C'est là que les utilisateurs font des demandes et reçoivent des réponses.

Client MCP Intégré à l'hôte, le client gère la communication du protocole. Il découvre les outils disponibles sur les serveurs connectés, traduit les demandes des utilisateurs en appels d'outils et gère le flux d'exécution.

Serveur MCP Un programme distinct exposant des capacités spécifiques via des interfaces standardisées. Dans les configurations locales, les serveurs s'exécutent sur la même machine et communiquent via l'entrée/sortie standard (stdio) — une méthode de communication directe entre processus qui élimine la surcharge réseau.

Architecture axée sur la confidentialité

Les serveurs locaux garantissent que les données sensibles ne quittent jamais votre machine. Lorsqu'une IA a besoin d'accéder à une base de code privée, à des fichiers personnels ou à des bases de données locales, le serveur traite les demandes entièrement sur l'appareil. Aucune information n'est transmise à des services externes.

Toutes les opérations nécessitent l'approbation explicite de l'utilisateur via l'application hôte. Les utilisateurs conservent un contrôle total sur ce que l'IA peut accéder, modifier ou exécuter, créant un modèle de confiance fondamentalement différent des alternatives basées sur le cloud.

Performance grâce à la communication directe

En utilisant stdio pour la communication entre processus, les serveurs locaux atteignent des temps de réponse mesurés en microsecondes plutôt qu'en millisecondes. Cette connexion directe élimine :

- La surcharge de sérialisation/désérialisation du réseau

- Les délais de handshake TLS

- La latence de routage Internet

- La limitation du débit des API

- Les temps d'attente dans la file d'attente du serveur

Pour les flux de travail impliquant des interactions fréquentes et de petite taille — analyse de code, navigation dans les fichiers ou recherches de données en temps réel — cette différence de performance transforme l'expérience utilisateur.

Capacité hors ligne d'abord

Les serveurs locaux fonctionnent indépendamment de la connectivité Internet. Les assistants IA peuvent continuer à fournir de la valeur pendant les vols, dans les zones à faible connectivité ou lors de pannes de réseau. Cette fiabilité rend les outils basés sur l'IA viables pour les flux de travail critiques où la connectivité ne peut être garantie.

Comment fonctionnent les serveurs MCP locaux : étape par étape

La mise en œuvre d'un serveur MCP local suit un processus simple, que vous utilisiez un serveur existant ou que vous construisiez une solution personnalisée.

Étape 1 : Installer le serveur MCP

Téléchargez ou construisez le programme serveur pour votre cas d'utilisation. Le dépôt Awesome MCP Servers propose des dizaines d'options pré-construites pour des tâches courantes comme l'accès au système de fichiers, l'intégration Git ou la connectivité à une base de données. Pour des besoins personnalisés, utilisez les SDK officiels disponibles en Python, Node.js ou C#.

Étape 2 : Configurer l'application hôte

Ajoutez le serveur au fichier de configuration de votre client IA (généralement au format JSON). Spécifiez le chemin de l'exécutable du serveur et tous les paramètres requis. Par exemple, une configuration de serveur de système de fichiers pourrait ressembler à ceci :

json{

"mcpServers": {

"filesystem": {

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-filesystem", "/Users/username/Documents"]

}

}

}

Étape 3 : Lancer et connecter

Lorsque vous démarrez l'application hôte, elle lance automatiquement les serveurs configurés en tant que processus enfants. Le client établit des canaux de communication stdio et effectue une poignée de main pour découvrir les outils et capacités disponibles.

Étape 4 : Accorder les autorisations

Lorsque l'IA tente d'utiliser les outils du serveur, l'application hôte demande l'approbation de l'utilisateur. Vous pouvez examiner exactement l'action que l'IA souhaite effectuer — lire un fichier spécifique, exécuter une commande ou interroger une base de données — avant d'accorder l'autorisation.

Étape 5 : Exécuter des flux de travail basés sur l'IA

Avec les serveurs connectés et les autorisations accordées, vous pouvez utiliser le langage naturel pour accomplir des tâches complexes. Demandez à l'IA de « trouver tous les commentaires TODO dans mon projet », « créer un nouveau composant React » ou « interroger la base de données locale pour les transactions récentes » — et l'IA orchestre les appels d'outils nécessaires via les serveurs connectés.

Applications et cas d'utilisation concrets

Les serveurs MCP locaux permettent des flux de travail IA sophistiqués dans les domaines du développement, de la recherche et de la productivité personnelle.

💻 Développement logiciel et gestion de code

Scénario : Un développeur doit refactoriser une grande base de code tout en maintenant la cohérence sur des centaines de fichiers.

Approche traditionnelle : Rechercher manuellement des motifs, mettre à jour chaque fichier individuellement, exécuter des tests et corriger les changements cassants — nécessitant des heures de travail concentré.

Avec les serveurs MCP locaux : L'IA utilise un serveur de système de fichiers pour scanner l'ensemble de la base de code, identifie toutes les instances nécessitant des modifications, propose des modifications et exécute les mises à jour sur plusieurs fichiers simultanément. Un serveur Git valide les changements avec des messages descriptifs.

Avantages clés :

- Compréhension sémantique du code grâce à l'intégration du serveur de langage

- Refactorisation automatisée sur des projets entiers

- Expérimentation sûre avec retour en arrière instantané via l'intégration Git

- Zéro risque d'exposition de code propriétaire

Selon l'analyse de l'architecture MCP par WorkOS, les développeurs utilisant des serveurs locaux pour l'assistance au codage rapportent des temps de réalisation 40 à 60 % plus rapides pour les tâches de refactorisation complexes.

📊 Analyse et gestion de bases de données locales

Scénario : Un analyste de données doit explorer une base de données PostgreSQL locale, comprendre les relations du schéma et générer des rapports.

Approche traditionnelle : Écrire manuellement des requêtes SQL, exporter les résultats vers des feuilles de calcul, créer des visualisations séparément — un flux de travail fragmenté nécessitant plusieurs outils.

Avec les serveurs MCP locaux : L'IA se connecte à la base de données locale via un serveur MCP, explore le schéma, génère des requêtes optimisées basées sur des demandes en langage naturel et formate les résultats directement dans la conversation.

Avantages clés :

- Requêtes de base de données en langage naturel sans expertise SQL

- Exploration automatique du schéma et cartographie des relations

- Les données sensibles restent entièrement sur l'appareil

- Jointures complexes multi-tables simplifiées grâce à l'assistance de l'IA

📱 Développement et tests mobiles

Scénario : Un développeur mobile doit tester une application iOS sur plusieurs configurations d'appareils et tailles d'écran.

Approche traditionnelle : Lancer manuellement des simulateurs, naviguer dans les flux de l'application, capturer des écrans et documenter les problèmes — répétitif et chronophage.

Avec les serveurs MCP locaux : Un serveur de simulateur iOS permet à l'IA de contrôler par programme les simulateurs, d'exécuter des scénarios de test, de capturer des écrans et de compiler automatiquement des rapports de test.

Avantages clés :

- Tests d'interface utilisateur automatisés sur différentes configurations d'appareils

- Création de cas de test en langage naturel

- Détection instantanée de régression visuelle

- Tests parallèles sur plusieurs simulateurs

🗂️ Gestion des connaissances personnelles

Scénario : Un chercheur gère des milliers de documents, d'articles et de notes dans divers dossiers et a besoin de trouver rapidement des informations spécifiques.

Approche traditionnelle : Utiliser la recherche du système de fichiers, ouvrir manuellement les documents, scanner le contenu et compiler les résultats — inefficace pour de grandes collections de documents.

Avec les serveurs MCP locaux : L'IA utilise un serveur de système de fichiers pour rechercher dans tous les documents, extraire les passages pertinents, résumer les résultats et créer des rapports organisés — tout en gardant les données de recherche sensibles en local.

Avantages clés :

- Recherche sémantique sur des collections entières de documents

- Résumé automatique et extraction d'informations

- Synthèse inter-documents et découverte de connexions

- Confidentialité totale pour la recherche confidentielle

Créer des serveurs MCP locaux personnalisés

La création d'un serveur MCP local personnalisé est accessible aux développeurs ayant des connaissances de base en programmation. Le guide de démarrage rapide officiel du serveur MCP fournit des tutoriels complets.

Aperçu du processus de développement

Choisissez votre SDK Des SDK officiels sont disponibles pour Python, TypeScript/Node.js et C#. Choisissez en fonction de votre langage préféré et de l'écosystème de bibliothèques que vous devez intégrer.

Définissez les fonctions de l'outil Implémentez la logique de base pour chaque capacité que vous souhaitez exposer. Par exemple, un outil de recherche de fichiers peut accepter une chaîne de requête et renvoyer les chemins des fichiers correspondants avec des extraits.

python@server.tool()

async def search_files(query: str, directory: str) -> list[dict]:

"""Search for files containing the query string."""

results = []

for root, dirs, files in os.walk(directory):

for file in files:

# Search logic here

pass

return results

Initialisez le serveur Utilisez la bibliothèque MCP pour créer une instance de serveur, enregistrer vos outils et configurer le transport stdio.

Gérez correctement la journalisation Comme stdio est utilisé pour la communication JSON-RPC, toute sortie superflue corrompt le protocole. Dirigez toute la journalisation vers stderr ou des fichiers journaux séparés :

pythonimport logging

logging.basicConfig(

level=logging.INFO,

handlers=[logging.FileHandler('server.log')]

)

Testez et déployez Testez votre serveur en le configurant dans une application hôte compatible. Vérifiez la découverte des outils, l'exécution et la gestion des erreurs avant de le distribuer.

Considérations de sécurité

Lors de la création de serveurs locaux, mettez en œuvre des mesures de sécurité appropriées :

- Validation des entrées : Assainissez tous les paramètres pour empêcher le path traversal ou l'injection de commandes.

- Portée des autorisations : Limitez l'accès du serveur à des répertoires ou des ressources spécifiques.

- Gestion des erreurs : Fournissez des messages d'erreur clairs sans exposer les détails internes du système.

- Journalisation d'audit : Enregistrez toutes les opérations pour un examen de sécurité.

Foire aux questions

En quoi les serveurs MCP locaux diffèrent-ils des API d'IA basées sur le cloud ?

Les serveurs MCP locaux s'exécutent entièrement sur votre machine et traitent les données sur l'appareil, tandis que les API cloud transmettent les données à des serveurs externes. Les serveurs locaux offrent une confidentialité supérieure, une latence plus faible (inférieure à la milliseconde contre 200-500ms) et une fonctionnalité hors ligne. Les API cloud offrent une plus grande puissance de calcul et une mise à l'échelle plus facile pour les tâches gourmandes en ressources. L'approche optimale combine souvent les deux : des serveurs locaux pour les opérations sensibles et des services cloud pour les calculs lourds.

Puis-je utiliser des serveurs MCP locaux avec n'importe quel assistant IA ?

Les serveurs MCP locaux fonctionnent avec toute application hôte qui implémente le protocole client MCP. Actuellement, cela inclut Claude Desktop, certains IDE améliorés par l'IA et des applications personnalisées construites avec les SDK MCP. À mesure que le protocole gagnera en adoption, de plus en plus d'outils d'IA ajouteront un support natif. Vous pouvez également créer votre propre application hôte en utilisant les bibliothèques clientes MCP officielles.

L'utilisation de serveurs MCP locaux nécessite-t-elle des connaissances en programmation ?

L'utilisation de serveurs pré-construits ne nécessite que des connaissances techniques minimales — généralement, il suffit de modifier un fichier de configuration JSON pour spécifier le chemin du serveur. La création de serveurs personnalisés nécessite des compétences en programmation en Python, TypeScript ou C#, mais les SDK et la documentation officiels rendent le processus accessible aux développeurs ayant une expérience de base. Le dépôt Awesome MCP Servers fournit des serveurs prêts à l'emploi pour les tâches courantes.

Quelles sont les exigences de performance pour exécuter des serveurs MCP locaux ?

Les serveurs MCP locaux ont une surcharge minimale car ce sont des programmes légers axés sur des tâches spécifiques. La plupart des serveurs consomment moins de 50 Mo de RAM et une quantité négligeable de CPU au repos. Les exigences de performance dépendent des opérations spécifiques — un serveur de système de fichiers a besoin d'E/S disque rapides, tandis qu'un serveur de base de données bénéficie d'une RAM adéquate pour la mise en cache des requêtes. Tout ordinateur moderne des 5 à 7 dernières années peut exécuter plusieurs serveurs locaux simultanément sans dégradation des performances.

Les serveurs MCP locaux sont-ils sécurisés pour une utilisation en entreprise ?

Les serveurs MCP locaux offrent une sécurité renforcée pour les environnements d'entreprise car les données ne quittent jamais la machine de l'utilisateur. Toutes les opérations nécessitent l'approbation explicite de l'utilisateur via l'application hôte. Cependant, les organisations devraient mettre en œuvre des contrôles supplémentaires : restreindre les serveurs que les employés peuvent installer, auditer le code source des serveurs pour les vulnérabilités de sécurité et appliquer des politiques d'autorisation via la configuration de l'application hôte. L'architecture sur l'appareil satisfait intrinsèquement à la plupart des réglementations sur la résidence des données et la confidentialité.

Les serveurs MCP locaux peuvent-ils fonctionner avec des services d'IA basés sur le cloud ?

Oui, les serveurs locaux et basés sur le cloud peuvent fonctionner ensemble de manière transparente au sein de l'architecture MCP. Un seul assistant IA peut utiliser des serveurs locaux pour des opérations sensibles (accès à des fichiers privés, interrogation de bases de données locales) tout en tirant parti des serveurs cloud pour des tâches gourmandes en ressources (traitement de données à grande échelle, intégrations d'API externes). Cette approche hybride combine la confidentialité et les performances des serveurs locaux avec l'évolutivité de l'infrastructure cloud.

Conclusion : L'avenir de l'intégration de l'IA axée sur la confidentialité

Les serveurs MCP locaux représentent un changement fondamental dans la manière dont les applications d'IA accèdent et traitent les données des utilisateurs. En conservant les informations sensibles sur l'appareil tout en permettant des capacités d'IA sophistiquées, ils résolvent la tension critique entre fonctionnalité et confidentialité qui a limité l'adoption de l'IA dans les environnements soucieux de la sécurité.

L'architecture standardisée du Model Context Protocol garantit qu'à mesure que l'écosystème se développe, les développeurs peuvent construire une fois et intégrer partout. Que vous étendiez un assistant IA existant avec des outils personnalisés ou que vous construisiez des applications entièrement nouvelles, les serveurs MCP locaux fournissent la base d'une intégration IA sécurisée et performante.

Pour les développeurs et les organisations qui privilégient la confidentialité des données, la fonctionnalité hors ligne et les performances en temps réel, les serveurs MCP locaux ne sont pas seulement une option — ils sont une infrastructure essentielle pour la prochaine génération d'outils basés sur l'IA.