Lokale MCP-Server-KI: KI-Tools mit Datenschutz und Leistung erweitern

2025-07-17

Lokale MCP-Server verändern die Art und Weise, wie KI-Anwendungen mit Ihren Daten und Tools interagieren, indem sie direkt auf Ihrem Rechner laufen. Im Gegensatz zu cloudbasierten Lösungen, die sensible Informationen über das Internet übertragen, verarbeiten lokale Server alles auf dem Gerät – das gewährleistet vollständige Privatsphäre und liefert nahezu sofortige Leistung.

Wesentliche Vorteile:

- ✅ Keine Datenübertragung an externe Server

- ✅ Antwortzeiten im Sub-Millisekunden-Bereich durch direkte Kommunikation

- ✅ Volle Offline-Funktionalität ohne Internetabhängigkeit

- ✅ Unbegrenzte Anpassungsmöglichkeiten für jeden lokalen Arbeitsablauf

Um zu verstehen, warum diese Architektur wichtig ist, betrachten wir die Herausforderungen, denen sich Entwickler und Organisationen heute beim Erstellen von KI-gestützten Anwendungen gegenübersehen.

Kurze Antwort: Was sind lokale MCP-Server?

Lokale MCP-Server sind Programme, die auf Ihrem Computer laufen, um KI-Fähigkeiten zu erweitern, indem sie sicheren, direkten Zugriff auf lokale Dateien, Datenbanken und Anwendungen bieten. Sie verwenden den Standard des Model Context Protocol (MCP), um Tools und Datenquellen für KI-Clients bereitzustellen, ohne Informationen über das Internet zu senden.

Wesentliche Fähigkeiten:

- Verarbeitung sensibler Daten vollständig auf dem Gerät für maximale Privatsphäre

- Ermöglichen der Interaktion von KI mit lokalen Dateien, Codebasen und Anwendungen

- Bereitstellung von Echtzeitleistung durch direkte Interprozesskommunikation

- Vollständige Offline-Funktionalität ohne Cloud-Abhängigkeiten

Das Problem: KI-Tools benötigen sicheren lokalen Zugriff

Da KI-Assistenten immer ausgefeilter werden, benötigen sie eine tiefere Integration in die persönlichen Umgebungen der Benutzer. Dies schafft jedoch grundlegende Herausforderungen:

73 % der Entwickler äußern Bedenken, dass KI-Tools auf ihre proprietären Codebasen und sensiblen Daten zugreifen.

Kritische Hindernisse für die KI-Einführung:

- Datenschutzrisiken – Übertragung sensibler Dateien und Daten an Cloud-Dienste

- Netzwerklatenz – Verzögerungen durch die Round-Trip-Kommunikation mit entfernten Servern

- Konnektivitätsanforderungen – Abhängigkeit von stabilen Internetverbindungen

- Begrenzte Anpassungsmöglichkeiten – Unfähigkeit zur Integration mit spezialisierten lokalen Tools

- Daten-Governance – Compliance-Herausforderungen mit unternehmensinternen Sicherheitsrichtlinien

Datenschutz- und Sicherheitsbedenken

Wenn KI-Tools eine Cloud-Konnektivität erfordern, muss jeder Dateizugriff, jede Datenbankabfrage oder jedes Code-Snippet an externe Server übertragen werden. Für Unternehmen, die mit proprietärem Code oder regulierten Daten arbeiten, stellt dies ein inakzeptables Risiko dar.

4,45 Millionen US-Dollar – Durchschnittliche Kosten einer Datenschutzverletzung im Jahr 2023, laut IBM Security.

Organisationen, die der GDPR, HIPAA oder anderen Datenschutzbestimmungen unterliegen, sehen sich bei der Nutzung von cloudbasierten KI-Diensten mit zusätzlichen Compliance-Belastungen konfrontiert. Selbst mit Verschlüsselung verstößt die Übertragung von Daten nach außen oft gegen interne Sicherheitsrichtlinien.

Leistungsengpässe

Cloudbasierte KI-Tools führen bei jeder Interaktion zu Latenz. Ein einfacher Dateilesevorgang, der lokal Mikrosekunden dauert, kann 100-500 Millisekunden benötigen, wenn er über entfernte Server geleitet wird.

200-300ms – Typische Round-Trip-Latenz für Cloud-API-Aufrufe, laut Cloudflare.

Bei interaktiven Arbeitsabläufen – Code-Vervollständigung, Echtzeit-Debugging oder schnelle Dateisuchen – summiert sich diese Verzögerung schnell und beeinträchtigt die Benutzererfahrung und Produktivität.

Offline-Einschränkungen

Cloud-abhängige KI-Tools werden ohne Internetverbindung völlig unbrauchbar. Entwickler, die auf Flügen, an abgelegenen Orten oder bei Netzwerkausfällen arbeiten, verlieren den Zugang zu kritischer KI-Unterstützung genau dann, wenn auch alternative Ressourcen begrenzt sind.

Die Lösung: Lokale MCP-Server für sichere KI-Erweiterung

Lokale MCP-Server lösen diese Herausforderungen, indem sie direkt auf Ihrem Rechner laufen und eine sichere Brücke zwischen KI-Clients und Ihrer lokalen Umgebung schaffen. Das Model Context Protocol bietet eine standardisierte Architektur für diese Integration.

| Traditionelle Cloud-KI | Lokale MCP-Server |

|---|---|

| Datenübertragung an externe Server | Gesamte Verarbeitung auf dem Gerät |

| 200-500ms Netzwerklatenz | Antwortzeiten im Sub-Millisekunden-Bereich |

| Benötigt Internetverbindung | Volle Offline-Funktionalität |

| Beschränkt auf vorgefertigte Integrationen | Unbegrenzte Erstellung benutzerdefinierter Tools |

| Datenzugriff durch Dritte | Benutzergesteuerte Berechtigungen |

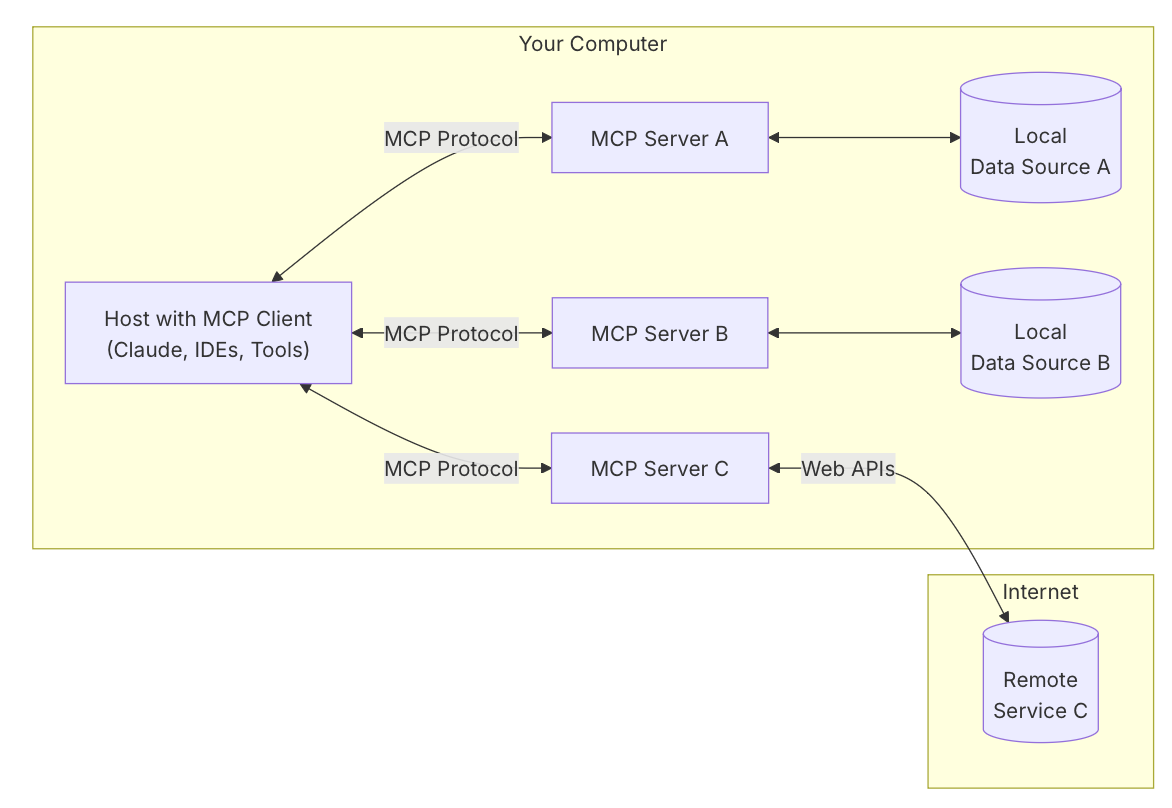

Die MCP-Architektur verstehen

Das Model Context Protocol basiert auf einem Drei-Komponenten-Modell:

Host-Anwendung Die primäre KI-gestützte Anwendung, mit der Benutzer interagieren – wie ein KI-Chat-Assistent, ein Code-Editor oder ein Desktop-Agent. Hier stellen Benutzer Anfragen und erhalten Antworten.

MCP-Client Eingebettet in den Host, übernimmt der Client die Protokollkommunikation. Er entdeckt verfügbare Tools von verbundenen Servern, übersetzt Benutzeranfragen in Tool-Aufrufe und verwaltet den Ausführungsfluss.

MCP-Server Ein separates Programm, das spezifische Fähigkeiten über standardisierte Schnittstellen bereitstellt. In lokalen Setups laufen die Server auf demselben Rechner und kommunizieren über Standard Input/Output (stdio) – eine direkte Interprozesskommunikationsmethode, die den Netzwerk-Overhead eliminiert.

Datenschutz-zuerst-Architektur

Lokale Server stellen sicher, dass sensible Daten niemals Ihren Rechner verlassen. Wenn eine KI auf eine private Codebasis, persönliche Dateien oder lokale Datenbanken zugreifen muss, verarbeitet der Server die Anfragen vollständig auf dem Gerät. Es werden keine Informationen an externe Dienste übertragen.

Alle Operationen erfordern die ausdrückliche Zustimmung des Benutzers über die Host-Anwendung. Benutzer behalten die vollständige Kontrolle darüber, worauf die KI zugreifen, was sie ändern oder ausführen kann – dies schafft ein Vertrauensmodell, das sich grundlegend von cloudbasierten Alternativen unterscheidet.

Leistung durch direkte Kommunikation

Durch die Verwendung von stdio für die Interprozesskommunikation erreichen lokale Server Antwortzeiten, die in Mikrosekunden statt Millisekunden gemessen werden. Diese direkte Verbindung eliminiert:

- Netzwerk-Serialisierungs-/Deserialisierungs-Overhead

- TLS-Handshake-Verzögerungen

- Internet-Routing-Latenz

- API-Ratenbegrenzung

- Wartezeiten in der Server-Warteschlange

Bei Arbeitsabläufen mit häufigen, kleinen Interaktionen – Code-Analyse, Datei-Navigation oder Echtzeit-Datenabfragen – verändert dieser Leistungsunterschied die Benutzererfahrung.

Offline-zuerst-Fähigkeit

Lokale Server funktionieren unabhängig von der Internetverbindung. KI-Assistenten können während Flügen, in Gebieten mit schlechter Konnektivität oder bei Netzwerkausfällen weiterhin Mehrwert bieten. Diese Zuverlässigkeit macht KI-gestützte Tools für geschäftskritische Arbeitsabläufe nutzbar, bei denen die Konnektivität nicht garantiert werden kann.

Wie lokale MCP-Server funktionieren: Schritt für Schritt

Die Implementierung eines lokalen MCP-Servers folgt einem unkomplizierten Prozess, egal ob Sie einen vorhandenen Server verwenden oder eine benutzerdefinierte Lösung erstellen.

Schritt 1: Installieren Sie den MCP-Server

Laden Sie das Serverprogramm für Ihren Anwendungsfall herunter oder erstellen Sie es. Das Awesome MCP Servers-Repository bietet Dutzende von vorgefertigten Optionen für gängige Aufgaben wie Dateisystemzugriff, Git-Integration oder Datenbankkonnektivität. Für benutzerdefinierte Anforderungen verwenden Sie offizielle SDKs, die in Python, Node.js oder C# verfügbar sind.

Schritt 2: Konfigurieren Sie die Host-Anwendung

Fügen Sie den Server zur Konfigurationsdatei Ihres KI-Clients hinzu (typischerweise im JSON-Format). Geben Sie den Pfad zur ausführbaren Datei des Servers und alle erforderlichen Parameter an. Zum Beispiel könnte eine Konfiguration für einen Dateisystem-Server so aussehen:

json{

"mcpServers": {

"filesystem": {

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-filesystem", "/Users/username/Documents"]

}

}

}

Schritt 3: Starten und Verbinden

Wenn Sie die Host-Anwendung starten, startet sie automatisch die konfigurierten Server als Kindprozesse. Der Client stellt stdio-Kommunikationskanäle her und führt einen Handshake durch, um verfügbare Tools und Fähigkeiten zu entdecken.

Schritt 4: Berechtigungen erteilen

Wenn die KI versucht, Server-Tools zu verwenden, fordert die Host-Anwendung die Zustimmung des Benutzers an. Sie können genau überprüfen, welche Aktion die KI ausführen möchte – das Lesen einer bestimmten Datei, das Ausführen eines Befehls oder das Abfragen einer Datenbank – bevor Sie die Erlaubnis erteilen.

Schritt 5: KI-gestützte Arbeitsabläufe ausführen

Mit verbundenen Servern und erteilten Berechtigungen können Sie natürliche Sprache verwenden, um komplexe Aufgaben zu erledigen. Bitten Sie die KI, „alle TODO-Kommentare in meinem Projekt zu finden“, „eine neue React-Komponente zu erstellen“ oder „die lokale Datenbank nach den letzten Transaktionen abzufragen“ – und die KI orchestriert die notwendigen Tool-Aufrufe über die verbundenen Server.

Reale Anwendungen und Anwendungsfälle

Lokale MCP-Server ermöglichen anspruchsvolle KI-Arbeitsabläufe in den Bereichen Entwicklung, Forschung und persönliche Produktivität.

💻 Softwareentwicklung und Code-Management

Szenario: Ein Entwickler muss eine große Codebasis refaktorisieren und dabei die Konsistenz über Hunderte von Dateien hinweg wahren.

Traditioneller Ansatz: Manuelles Suchen nach Mustern, individuelles Aktualisieren jeder Datei, Ausführen von Tests und Beheben von Fehlern – was Stunden konzentrierter Arbeit erfordert.

Mit lokalen MCP-Servern: Die KI verwendet einen Dateisystem-Server, um die gesamte Codebasis zu scannen, identifiziert alle Instanzen, die Änderungen erfordern, schlägt Änderungen vor und führt Aktualisierungen über mehrere Dateien gleichzeitig aus. Ein Git-Server committet die Änderungen mit beschreibenden Nachrichten.

Wesentliche Vorteile:

- Semantisches Code-Verständnis durch Integration von Sprachservern

- Automatisiertes Refactoring über ganze Projekte hinweg

- Sicheres Experimentieren mit sofortigem Rollback über Git-Integration

- Kein Risiko der Offenlegung von proprietärem Code

Laut WorkOS' Analyse der MCP-Architektur berichten Entwickler, die lokale Server zur Code-Unterstützung verwenden, von 40-60 % schnelleren Abschlusszeiten für komplexe Refactoring-Aufgaben.

📊 Lokale Datenbankanalyse und -verwaltung

Szenario: Ein Datenanalyst muss eine lokale PostgreSQL-Datenbank untersuchen, Schema-Beziehungen verstehen und Berichte erstellen.

Traditioneller Ansatz: Manuelles Schreiben von SQL-Abfragen, Exportieren der Ergebnisse in Tabellenkalkulationen, separates Erstellen von Visualisierungen – ein fragmentierter Arbeitsablauf, der mehrere Tools erfordert.

Mit lokalen MCP-Servern: Die KI verbindet sich über einen MCP-Server mit der lokalen Datenbank, untersucht das Schema, generiert optimierte Abfragen basierend auf Anfragen in natürlicher Sprache und formatiert die Ergebnisse direkt im Gespräch.

Wesentliche Vorteile:

- Datenbankabfragen in natürlicher Sprache ohne SQL-Kenntnisse

- Automatische Schema-Erkundung und Beziehungszuordnung

- Sensible Daten bleiben vollständig auf dem Gerät

- Komplexe Joins über mehrere Tabellen werden durch KI-Unterstützung vereinfacht

📱 Mobile Entwicklung und Tests

Szenario: Ein Mobilentwickler muss eine iOS-App auf verschiedenen Gerätekonfigurationen und Bildschirmgrößen testen.

Traditioneller Ansatz: Manuelles Starten von Simulatoren, Navigieren durch App-Abläufe, Erfassen von Screenshots und Dokumentieren von Problemen – repetitiv und zeitaufwändig.

Mit lokalen MCP-Servern: Ein iOS-Simulator-Server ermöglicht es der KI, Simulatoren programmatisch zu steuern, Testszenarien auszuführen, Screenshots zu erfassen und Testberichte automatisch zu erstellen.

Wesentliche Vorteile:

- Automatisierte UI-Tests über verschiedene Gerätekonfigurationen hinweg

- Erstellung von Testfällen in natürlicher Sprache

- Sofortige Erkennung visueller Regressionen

- Paralleles Testen auf mehreren Simulatoren

🗂️ Persönliches Wissensmanagement

Szenario: Ein Forscher verwaltet Tausende von Dokumenten, Papieren und Notizen in verschiedenen Ordnern und muss schnell spezifische Informationen finden.

Traditioneller Ansatz: Verwendung der Dateisystemsuche, manuelles Öffnen von Dokumenten, Scannen von Inhalten und Zusammenstellen von Ergebnissen – ineffizient bei großen Dokumentensammlungen.

Mit lokalen MCP-Servern: Die KI verwendet einen Dateisystem-Server, um alle Dokumente zu durchsuchen, relevante Passagen zu extrahieren, Ergebnisse zusammenzufassen und organisierte Berichte zu erstellen – alles, während sensible Forschungsdaten lokal bleiben.

Wesentliche Vorteile:

- Semantische Suche über ganze Dokumentensammlungen

- Automatische Zusammenfassung und Informationsextraktion

- Dokumentübergreifende Synthese und Verbindungserkennung

- Vollständige Privatsphäre für vertrauliche Forschung

Erstellen benutzerdefinierter lokaler MCP-Server

Das Erstellen eines benutzerdefinierten lokalen MCP-Servers ist für Entwickler mit grundlegenden Programmierkenntnissen zugänglich. Die offizielle MCP-Server-Schnellstartanleitung bietet umfassende Tutorials.

Überblick über den Entwicklungsprozess

Wählen Sie Ihr SDK Offizielle SDKs sind für Python, TypeScript/Node.js und C# verfügbar. Wählen Sie basierend auf Ihrer bevorzugten Sprache und dem Ökosystem der Bibliotheken, die Sie integrieren müssen.

Definieren Sie Tool-Funktionen Implementieren Sie die Kernlogik für jede Fähigkeit, die Sie bereitstellen möchten. Zum Beispiel könnte ein Dateisuch-Tool eine Suchanfrage akzeptieren und passende Dateipfade mit Auszügen zurückgeben.

python@server.tool()

async def search_files(query: str, directory: str) -> list[dict]:

"""Search for files containing the query string."""

results = []

for root, dirs, files in os.walk(directory):

for file in files:

# Search logic here

pass

return results

Initialisieren Sie den Server Verwenden Sie die MCP-Bibliothek, um eine Serverinstanz zu erstellen, Ihre Tools zu registrieren und den stdio-Transport zu konfigurieren.

Protokollierung korrekt handhaben Da stdio für die JSON-RPC-Kommunikation verwendet wird, beschädigt jede überflüssige Ausgabe das Protokoll. Leiten Sie alle Protokollierungen an stderr oder separate Protokolldateien um:

pythonimport logging

logging.basicConfig(

level=logging.INFO,

handlers=[logging.FileHandler('server.log')]

)

Testen und Bereitstellen Testen Sie Ihren Server, indem Sie ihn in einer kompatiblen Host-Anwendung konfigurieren. Überprüfen Sie die Tool-Erkennung, Ausführung und Fehlerbehandlung vor der Verteilung.

Sicherheitsüberlegungen

Beim Erstellen lokaler Server sollten Sie geeignete Sicherheitsmaßnahmen implementieren:

- Eingabevalidierung: Bereinigen Sie alle Parameter, um Path Traversal oder Command Injection zu verhindern.

- Berechtigungsbereich: Beschränken Sie den Serverzugriff auf bestimmte Verzeichnisse oder Ressourcen.

- Fehlerbehandlung: Geben Sie klare Fehlermeldungen aus, ohne Systeminterna preiszugeben.

- Audit-Protokollierung: Zeichnen Sie alle Operationen zur Sicherheitsüberprüfung auf.

Häufig gestellte Fragen

Wie unterscheiden sich lokale MCP-Server von cloudbasierten KI-APIs?

Lokale MCP-Server laufen vollständig auf Ihrem Rechner und verarbeiten Daten auf dem Gerät, während Cloud-APIs Daten an externe Server übertragen. Lokale Server bieten überlegene Privatsphäre, geringere Latenz (Sub-Millisekunden vs. 200-500ms) und Offline-Funktionalität. Cloud-APIs bieten größere Rechenleistung und einfachere Skalierbarkeit für ressourcenintensive Aufgaben. Der optimale Ansatz kombiniert oft beides: lokale Server für sensible Operationen und Cloud-Dienste für aufwändige Berechnungen.

Kann ich lokale MCP-Server mit jedem KI-Assistenten verwenden?

Lokale MCP-Server funktionieren mit jeder Host-Anwendung, die das MCP-Client-Protokoll implementiert. Derzeit gehören dazu Claude Desktop, bestimmte KI-erweiterte IDEs und benutzerdefinierte Anwendungen, die mit MCP-SDKs erstellt wurden. Mit zunehmender Verbreitung des Protokolls werden mehr KI-Tools native Unterstützung hinzufügen. Sie können auch Ihre eigene Host-Anwendung mit offiziellen MCP-Client-Bibliotheken erstellen.

Benötigen lokale MCP-Server Programmierkenntnisse zur Verwendung?

Die Verwendung vorgefertigter Server erfordert minimale technische Kenntnisse – typischerweise nur das Bearbeiten einer JSON-Konfigurationsdatei, um den Serverpfad anzugeben. Das Erstellen benutzerdefinierter Server erfordert Programmierkenntnisse in Python, TypeScript oder C#, aber die offiziellen SDKs und die Dokumentation machen den Prozess für Entwickler mit grundlegender Erfahrung zugänglich. Das Awesome MCP Servers Repository bietet gebrauchsfertige Server für gängige Aufgaben.

Was sind die Leistungsanforderungen für den Betrieb lokaler MCP-Server?

Lokale MCP-Server haben einen minimalen Overhead, da es sich um leichtgewichtige Programme handelt, die auf bestimmte Aufgaben ausgerichtet sind. Die meisten Server verbrauchen im Leerlauf weniger als 50 MB RAM und vernachlässigbare CPU-Leistung. Die Leistungsanforderungen hängen von den spezifischen Operationen ab – ein Dateisystem-Server benötigt schnelle Festplatten-I/O, während ein Datenbank-Server von ausreichend RAM für das Query-Caching profitiert. Jeder moderne Computer der letzten 5-7 Jahre kann mehrere lokale Server gleichzeitig ohne Leistungseinbußen betreiben.

Sind lokale MCP-Server sicher für den Unternehmenseinsatz?

Lokale MCP-Server bieten eine starke Sicherheit für Unternehmensumgebungen, da die Daten niemals den Rechner des Benutzers verlassen. Alle Operationen erfordern die ausdrückliche Zustimmung des Benutzers über die Host-Anwendung. Organisationen sollten jedoch zusätzliche Kontrollen implementieren: einschränken, welche Server Mitarbeiter installieren dürfen, den Quellcode der Server auf Sicherheitslücken prüfen und Berechtigungsrichtlinien über die Konfiguration der Host-Anwendung durchsetzen. Die On-Device-Architektur erfüllt von Natur aus die meisten Vorschriften zur Datenresidenz und zum Datenschutz.

Können lokale MCP-Server neben cloudbasierten KI-Diensten arbeiten?

Ja, lokale und cloudbasierte Server können nahtlos innerhalb der MCP-Architektur zusammenarbeiten. Ein einzelner KI-Assistent kann lokale Server für sensible Operationen (Zugriff auf private Dateien, Abfragen lokaler Datenbanken) verwenden, während er Cloud-Server für ressourcenintensive Aufgaben (groß angelegte Datenverarbeitung, externe API-Integrationen) nutzt. Dieser hybride Ansatz kombiniert den Datenschutz und die Leistung lokaler Server mit der Skalierbarkeit der Cloud-Infrastruktur.

Fazit: Die Zukunft der datenschutzorientierten KI-Integration

Lokale MCP-Server stellen einen grundlegenden Wandel in der Art und Weise dar, wie KI-Anwendungen auf Benutzerdaten zugreifen und diese verarbeiten. Indem sie sensible Informationen auf dem Gerät halten und gleichzeitig anspruchsvolle KI-Fähigkeiten ermöglichen, lösen sie die kritische Spannung zwischen Funktionalität und Datenschutz, die die KI-Einführung in sicherheitsbewussten Umgebungen bisher eingeschränkt hat.

Die standardisierte Architektur des Model Context Protocol stellt sicher, dass Entwickler, während das Ökosystem wächst, einmal bauen und überall integrieren können. Ob Sie einen bestehenden KI-Assistenten mit benutzerdefinierten Tools erweitern oder völlig neue Anwendungen erstellen, lokale MCP-Server bieten die Grundlage für eine sichere, leistungsstarke KI-Integration.

Für Entwickler und Organisationen, die Datenschutz, Offline-Funktionalität und Echtzeitleistung priorisieren, sind lokale MCP-Server nicht nur eine Option – sie sind eine wesentliche Infrastruktur für die nächste Generation von KI-gestützten Tools.